AI Agents đang nhanh chóng trở thành một phần không thể thiếu trong quy trình làm việc của khách hàng ở nhiều ngành công nghiệp, nhờ khả năng tự động hóa các tác vụ phức tạp, nâng cao chất lượng ra quyết định và tối ưu hóa hoạt động. Tuy nhiên, việc triển khai các tác nhân AI vào hệ thống sản xuất đòi hỏi những quy trình đánh giá có khả năng mở rộng. Một hệ thống đánh giá tác nhân hiệu quả sẽ giúp đo lường mức độ hoàn thành nhiệm vụ của tác nhân, từ đó cung cấp những hiểu biết quan trọng để tăng cường an toàn, kiểm soát, độ tin cậy, tính minh bạch và hiệu suất của tác nhân AI.

Amazon Bedrock Agents tận dụng khả năng suy luận của các mô hình nền tảng (foundation models – FMs) có sẵn trên Amazon Bedrock, cùng với các API và dữ liệu, để phân tích các yêu cầu của người dùng, thu thập thông tin liên quan và hoàn thành tác vụ một cách hiệu quả — từ đó giúp các nhóm làm việc tập trung hơn vào những công việc có giá trị cao. Bạn có thể kích hoạt các ứng dụng AI tạo sinh để tự động hóa các tác vụ nhiều bước bằng cách kết nối liền mạch với hệ thống nội bộ, API và nguồn dữ liệu của công ty.

Ragas là một thư viện mã nguồn mở dùng để kiểm thử và đánh giá các ứng dụng sử dụng mô hình ngôn ngữ lớn (LLM), bao gồm cả các trường hợp sử dụng như RAG (Retrieval Augmented Generation). Framework này cho phép đo lường định lượng hiệu quả của việc triển khai RAG. Trong bài viết này, chúng tôi sử dụng thư viện Ragas để đánh giá năng lực RAG của Amazon Bedrock Agents.

LLM-as-a-judge là một phương pháp đánh giá sử dụng mô hình ngôn ngữ lớn để thẩm định chất lượng đầu ra do AI tạo ra. Cách tiếp cận này cho phép một mô hình LLM đóng vai trò giám khảo trung lập, phân tích và chấm điểm đầu ra. Trong bài viết này, chúng tôi áp dụng kỹ thuật LLM-as-a-judge để đánh giá khả năng chuyển đổi văn bản thành truy vấn SQL (text-to-SQL) và lập chuỗi suy luận (chain-of-thought) của Amazon Bedrock Agents.

Langfuse là một nền tảng kỹ thuật LLM mã nguồn mở, cung cấp các tính năng như truy vết (trace), đánh giá (eval), quản lý prompt và theo dõi chỉ số để gỡ lỗi và cải thiện ứng dụng LLM của bạn.

Trong bài viết “Thúc đẩy phân tích và khám phá biomarker ung thư với Amazon Bedrock Agents”, chúng tôi đã giới thiệu các tác nhân nghiên cứu trong lĩnh vực dược phẩm. Trong bài viết này, chúng tôi mở rộng công trình đó và giới thiệu cách đánh giá các Bedrock Agent mã nguồn mở với các năng lực sau:

-

Đánh giá Amazon Bedrock Agents theo các tiêu chí như: khả năng RAG, text-to-SQL, sử dụng công cụ tùy chỉnh và tổng thể chuỗi suy luận

-

Kết quả đánh giá toàn diện cùng dữ liệu truy vết được gửi đến Langfuse với bảng điều khiển trực quan tích hợp sẵn

-

Phân tích truy vết và đánh giá theo nhiều cấu hình khác nhau của Amazon Bedrock Agents

Trước tiên, chúng tôi tiến hành đánh giá trên nhiều loại tác nhân Amazon Bedrock khác nhau. Các tác nhân này bao gồm: một tác nhân mẫu RAG, một tác nhân mẫu text-to-SQL và các tác nhân nghiên cứu trong lĩnh vực dược phẩm sử dụng mô hình hợp tác đa tác nhân để khám phá biomarker ung thư. Sau đó, với mỗi tác nhân, chúng tôi sẽ hướng dẫn cách sử dụng bảng điều khiển của Langfuse để theo dõi truy vết và kết quả đánh giá.

Tìm hiểu thêm: https://osam.io/genai-xu-huong-giao-duc-2025/

https://osam.io/nang-cao-tim-kiem-ai-opensearch-bedrock/

Các thách thức kỹ thuật

Ngày nay, các nhà phát triển Agents AI thường đối mặt với những thách thức kỹ thuật sau:

-

Đánh giá Agents toàn diện – Mặc dù Amazon Bedrock cung cấp các khả năng đánh giá tích hợp cho các mô hình LLM và việc truy xuất RAG, nhưng vẫn thiếu các chỉ số được thiết kế riêng cho Amazon Bedrock Agents. Cần phải có phương pháp đánh giá mục tiêu Agents toàn diện, cũng như các bước truy vết của Agents cho các nhiệm vụ và công cụ cụ thể. Hỗ trợ cũng cần có cho cả Agents đơn lẻ và đa Agents, cùng với cả bộ dữ liệu đơn và đa lượt (single-turn and multi-turn datasets).

-

Quản lý thí nghiệm đầy thử thách – Amazon Bedrock Agents cung cấp nhiều tùy chọn cấu hình, bao gồm lựa chọn mô hình LLM, hướng dẫn Agents, cấu hình công cụ và thiết lập đa Agents. Tuy nhiên, việc thực hiện thí nghiệm nhanh chóng với các tham số này gặp khó khăn về mặt kỹ thuật do thiếu các phương pháp hệ thống để theo dõi, so sánh và đo lường tác động của các thay đổi cấu hình qua các phiên bản Agents khác nhau. Điều này làm cho việc tối ưu hóa hiệu suất Agents qua các lần thử nghiệm lặp lại trở nên khó khăn.

Tổng quan về giải pháp

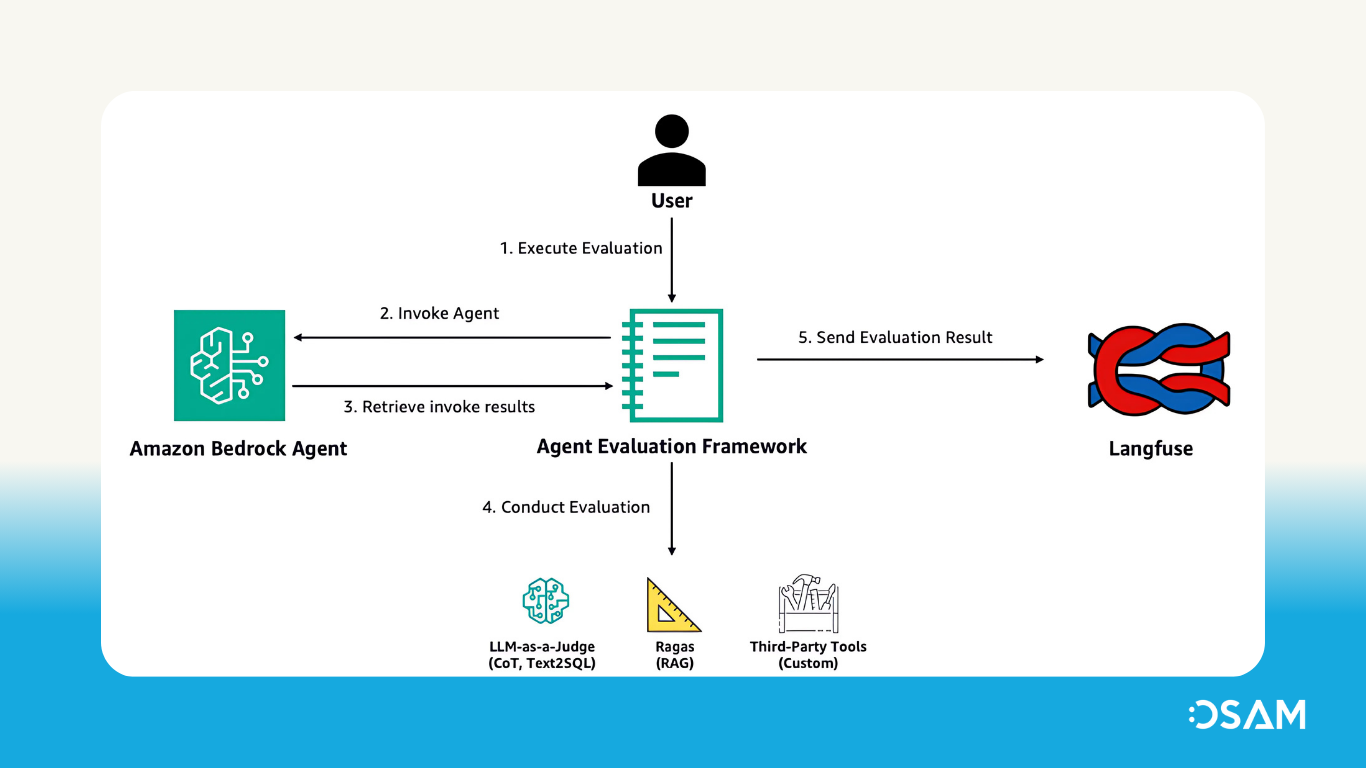

Hình dưới đây minh họa cách thức Đánh giá Agents Bedrock Mã nguồn Mở hoạt động ở cấp độ tổng quan. Framework này thực hiện một công việc đánh giá, sẽ gọi Agents của bạn trong Amazon Bedrock và đánh giá phản hồi của nó.

Quy trình làm việc bao gồm các bước sau:

-

Người dùng chỉ định ID Agents, bí danh (alias), mô hình đánh giá và bộ dữ liệu chứa các cặp câu hỏi và đáp án chuẩn (ground truth).

-

Người dùng thực thi tác vụ đánh giá, trong đó sẽ gọi đến Agents Amazon Bedrock đã được chỉ định.

-

Các truy vết (trace) thu được từ quá trình gọi Agents sẽ được xử lý qua logic phân tích tùy chỉnh trong framework.

-

Framework tiến hành đánh giá dựa trên kết quả gọi Agents và loại câu hỏi:

-

Chain-of-thought – Đánh giá bằng kỹ thuật LLM-as-a-judge, sử dụng các cuộc gọi tới mô hình LLM trên Amazon Bedrock (được thực hiện trong mỗi lần đánh giá với các loại câu hỏi khác nhau)

-

RAG – Sử dụng thư viện đánh giá Ragas

-

Text-to-SQL – Cũng sử dụng LLM-as-a-judge với Amazon Bedrock LLM

-

-

Kết quả đánh giá và các truy vết đã được phân tích sẽ được tổng hợp và gửi đến Langfuse để cung cấp cái nhìn chuyên sâu về quá trình đánh giá.

Yêu cầu tiên quyết

Để triển khai các Agents mẫu như RAG và text-to-SQL, đồng thời thực hiện đánh giá bằng cách sử dụng Open Source Bedrock Agent Evaluation, hãy làm theo hướng dẫn trong phần Triển khai các Agents mẫu để đánh giá.

Để sử dụng Agents của riêng bạn với framework này, hãy tham khảo README đi kèm và làm theo hướng dẫn chi tiết để triển khai Open Source Bedrock Agent Evaluation framework.

Tổng quan về các chỉ số đánh giá và dữ liệu đầu vào

Trước tiên, chúng tôi tạo các Amazon Bedrock Agents mẫu để minh họa các khả năng của Open Source Bedrock Agent Evaluation.

-

Text-to-SQL Agent sử dụng bộ dữ liệu BirdSQL Mini-Dev

-

RAG Agent sử dụng bộ dữ liệu rag-mini-wikipedia từ Hugging Face

Các chỉ số đánh giá

Framework Open Source Bedrock Agent Evaluation tiến hành đánh giá theo hai loại chỉ số chính:

-

Mục tiêu của Agents – Chain-of-thought (chạy cho mọi câu hỏi)

-

Độ chính xác theo nhiệm vụ – RAG, text-to-SQL (chỉ chạy khi công cụ tương ứng được sử dụng để trả lời câu hỏi)

1. Chỉ số về Mục tiêu của Agents

Đo lường mức độ mà một Agents hiểu và đạt được mục tiêu của người dùng. Có hai loại chính:

-

Đánh giá có tham chiếu (Reference-based evaluation): Người dùng cung cấp một kết quả lý tưởng, được dùng làm chuẩn so sánh với kết quả do Agents thực hiện.

-

Đánh giá không có tham chiếu (Evaluation without reference): Đánh giá hiệu suất của LLM trong việc hiểu và đạt được mục tiêu của người dùng mà không cần so sánh với chuẩn.

Trong bài viết này, chúng tôi trình bày đánh giá không có tham chiếu bằng phương pháp Chain-of-thought, bằng cách so sánh giữa quá trình suy luận và hướng dẫn dành cho Agents. Các chỉ số đánh giá được lấy từ các evaluator prompt dành cho kỹ thuật LLM-as-a-judge của Amazon Bedrock.

2. Chỉ số về Độ chính xác theo nhiệm vụ

Đo lường mức độ Agents sử dụng đúng công cụ cần thiết để hoàn thành một nhiệm vụ nhất định.

Đối với hai loại đánh giá nhiệm vụ là RAG và text-to-SQL, việc đánh giá dựa trên việc so sánh câu trả lời thực tế từ Agents với tập dữ liệu đáp án chuẩn (ground truth) được cung cấp.

Các chỉ số này chỉ được đánh giá khi Agents sử dụng đúng công cụ để trả lời câu hỏi.

Chi tiết các chỉ số theo từng loại đánh giá:

🔹 RAG

-

Faithfulness – Mức độ chính xác thực tế của câu trả lời so với ngữ cảnh đã truy xuất

-

Answer relevancy – Mức độ câu hỏi gốc được giải quyết một cách trực tiếp và phù hợp

-

Context recall – Mức độ thông tin liên quan được truy xuất thành công

-

Semantic similarity – Mức độ tương đồng ngữ nghĩa giữa câu trả lời và đáp án chuẩn

🔹 Text-to-SQL

-

SQL query semantic equivalence – Mức độ tương đương về ngữ nghĩa giữa câu truy vấn sinh ra và câu truy vấn tham chiếu

-

Answer correctness – Mức độ câu trả lời phản ánh đúng kết quả của câu truy vấn và khớp với ground truth

🔹 Chain-of-thought

-

Helpfulness – Mức độ mà Agents đáp ứng kỳ vọng rõ ràng và ẩn ý của người dùng

-

Faithfulness – Mức độ Agents tuân thủ thông tin và ngữ cảnh sẵn có

-

Instruction following – Mức độ Agents làm theo đúng các chỉ dẫn rõ ràng

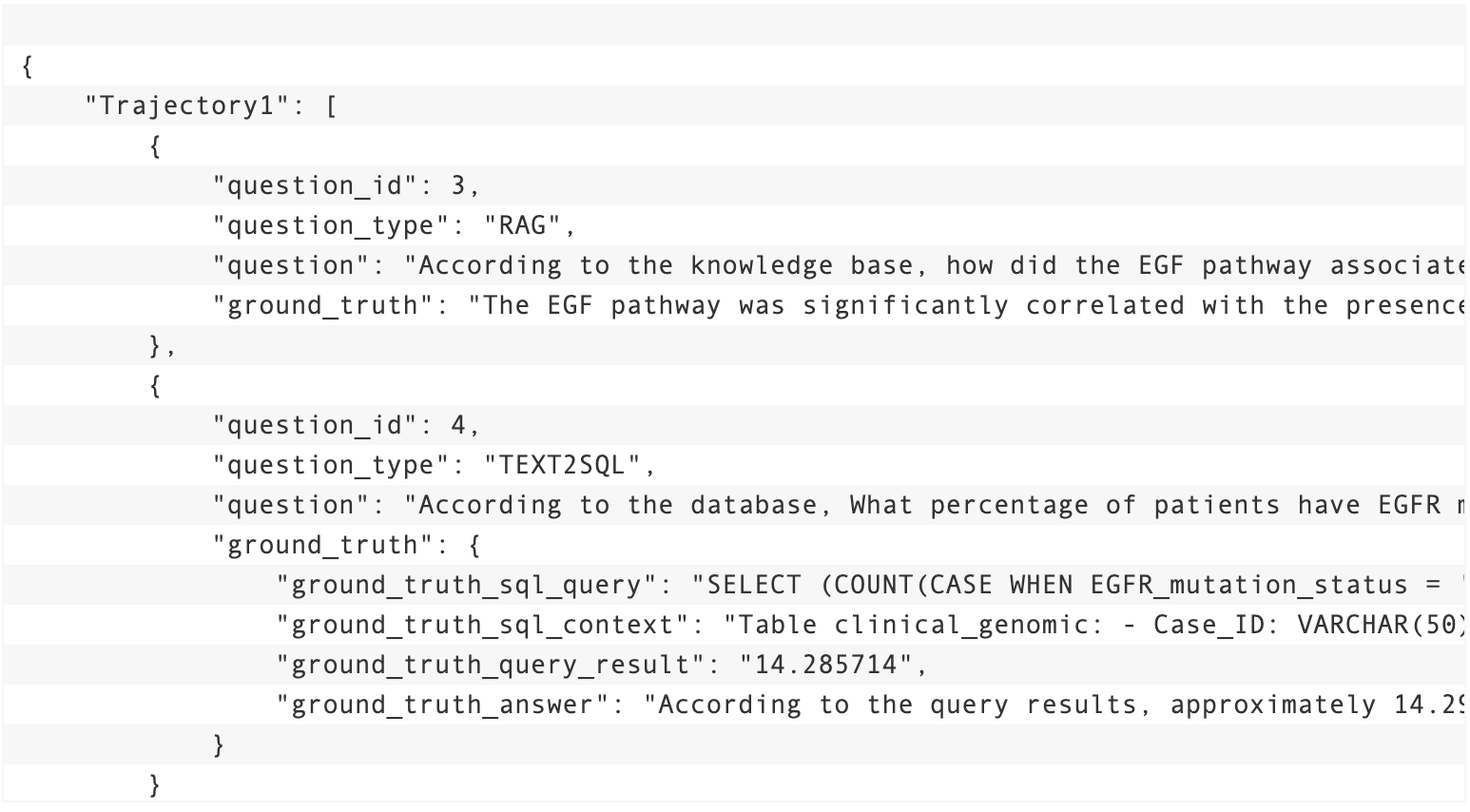

Tương tác người dùng – Agents (User-Agent trajectories)

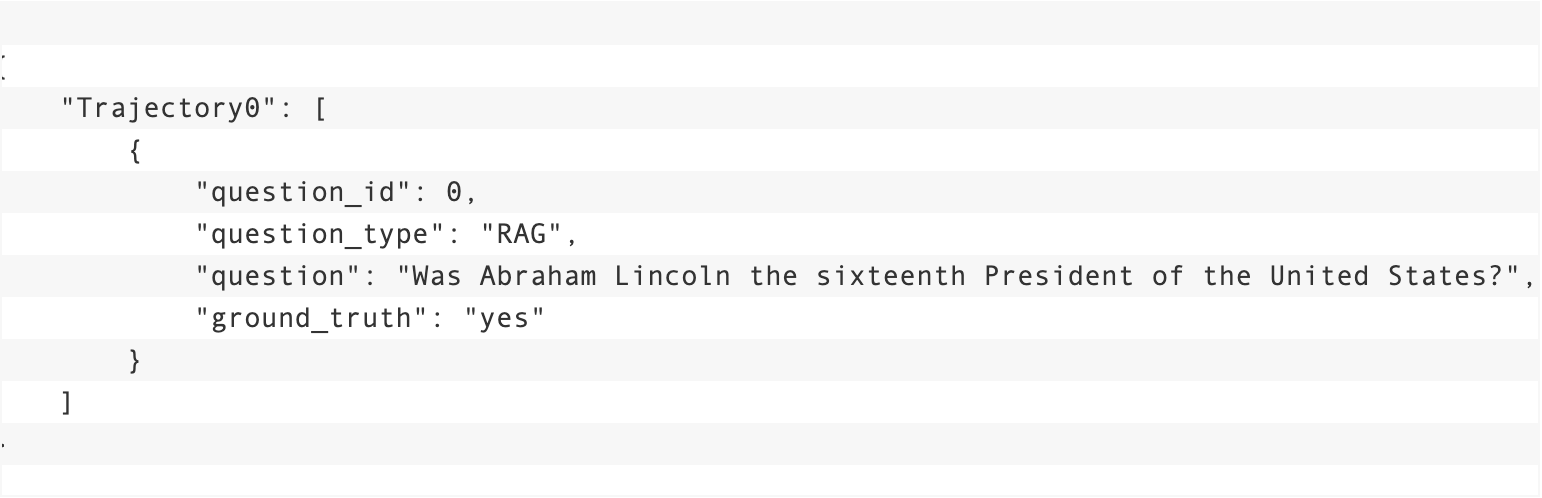

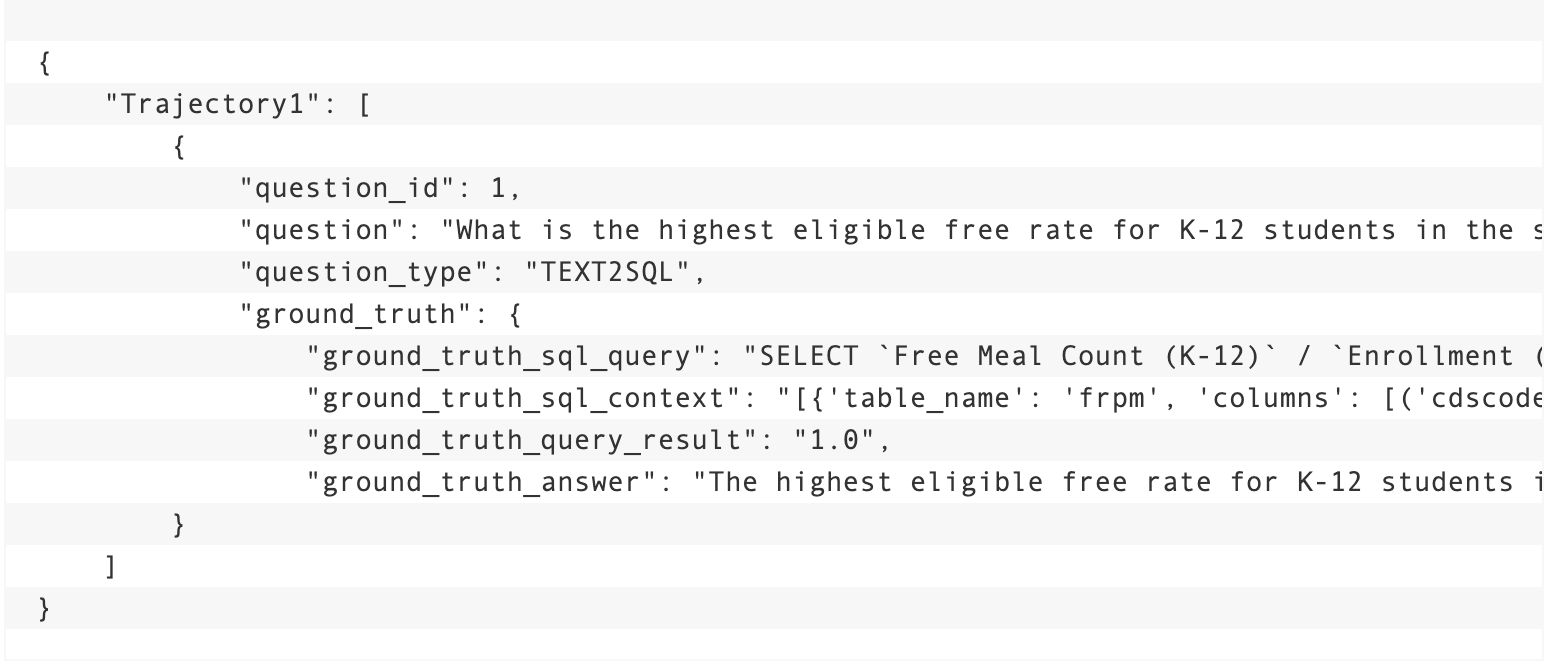

Tập dữ liệu đầu vào có dạng trajectories, trong đó mỗi trajectory bao gồm một hoặc nhiều câu hỏi được gửi tới Agents. Các trajectory này mô phỏng cách người dùng có thể tương tác với Agents trong thực tế.

Mỗi trajectory bao gồm các trường:

-

question_id(mã định danh) -

question_type(loại câu hỏi) -

question(nội dung câu hỏi) -

ground_truth(đáp án chuẩn)

Đối với các thiết lập đơn giản như Agents RAG và text-to-SQL, chúng tôi tạo các trajectory chỉ chứa một câu hỏi duy nhất, như minh họa trong các ví dụ sau.

Dưới đây là ví dụ về một trajectory của Agent mẫu RAG:

Dưới đây là ví dụ về một trajectory của Agent mẫu Text-to-SQL:

Ví dụ về trường hợp sử dụng Agents nghiên cứu dược phẩm

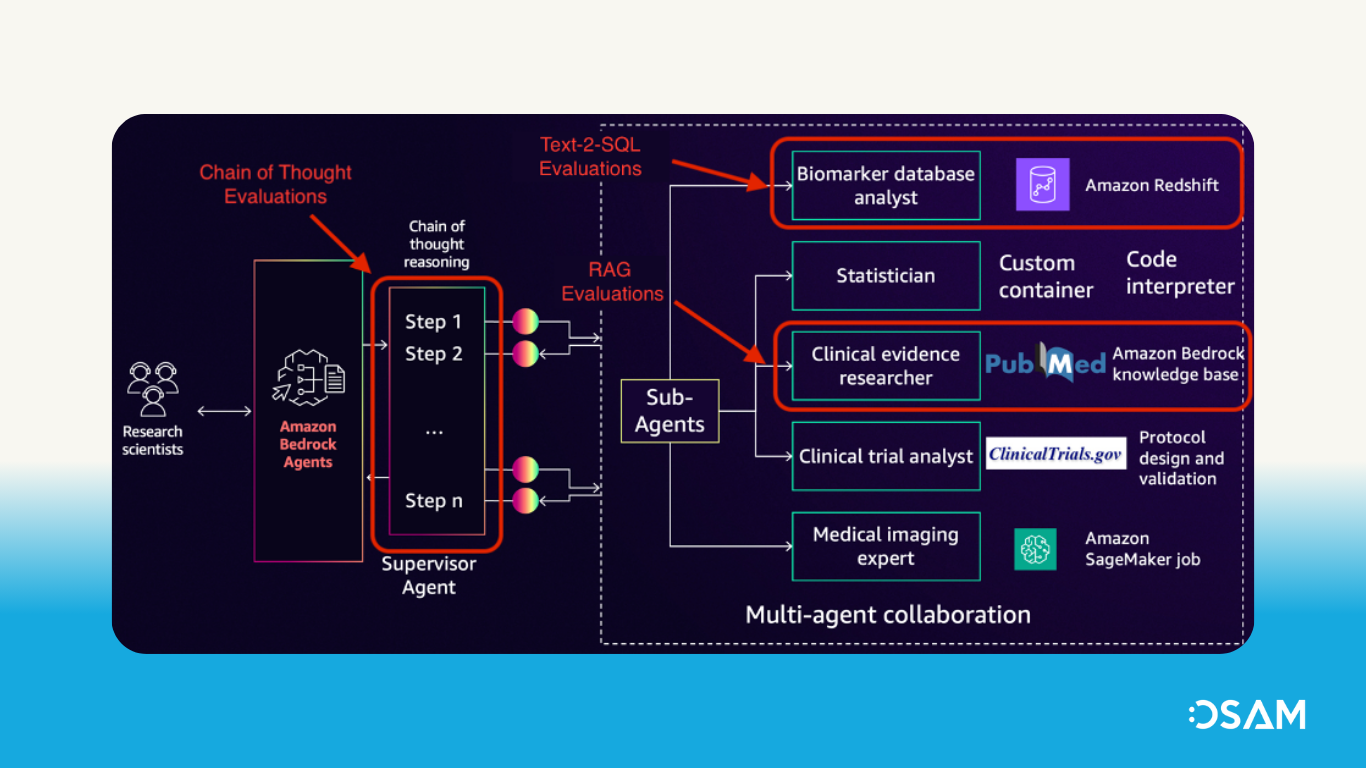

Trong phần này, chúng tôi trình bày cách bạn có thể sử dụng framework Đánh giá Agents Bedrock mã nguồn mở để đánh giá các Agents nghiên cứu dược phẩm đã được đề cập trong bài viết “Thúc đẩy phân tích và khám phá các dấu ấn sinh học ung thư với Amazon Bedrock Agents”. Phần này minh hoạ nhiều Agents chuyên biệt, bao gồm: nhà phân tích cơ sở dữ liệu dấu ấn sinh học, nhà thống kê, nhà nghiên cứu bằng chứng lâm sàng, và chuyên gia hình ảnh y tế — tất cả cùng hợp tác với một Agent giám sát.

Pharmaceutical research Agent được xây dựng dựa trên tính năng hợp tác đa Agents của Amazon Bedrock. Sơ đồ dưới đây mô tả thiết lập đa Agents đã được đánh giá thông qua framework này.

Các trajectory của Agents nghiên cứu

Với một thiết lập phức tạp hơn như pharmaceutical research Agents, chúng tôi đã sử dụng một tập hợp các câu hỏi kiểm thử được tạo sẵn, có liên quan đến ngành. Bằng cách nhóm các câu hỏi theo chủ đề — bất kể sub-Agents nào sẽ được gọi để trả lời — chúng tôi đã tạo ra các trajectories bao gồm nhiều câu hỏi và sử dụng nhiều loại công cụ khác nhau. Với các câu hỏi phù hợp đã được tạo, việc tích hợp với framework đánh giá chỉ đơn giản là định dạng lại dữ liệu ground truth thành các trajectory phù hợp.

Chúng tôi sẽ hướng dẫn cách đánh giá Agent này với một trajectory chứa cả câu hỏi RAG và câu hỏi Text-to-SQL:

Đánh giá theo chuỗi suy luận (Chain-of-thought) được thực hiện cho mọi câu hỏi, bất kể có sử dụng công cụ hay không. Điều này sẽ được minh hoạ thông qua một loạt hình ảnh về trace của Agent và các kết quả đánh giá trên bảng điều khiển Langfuse.

Sau khi chạy Agent với trajectory đã cho, các kết quả sẽ được gửi đến Langfuse để xem các chỉ số đánh giá. Ảnh chụp màn hình dưới đây hiển thị trace của câu hỏi RAG (question ID 3) trong quá trình đánh giá trên Langfuse.

Ảnh chụp màn hình hiển thị các thông tin sau:

-

Thông tin trace (đầu vào và đầu ra của lần gọi Agent)

-

Các bước trace (quá trình sinh nội dung của Agent và các bước con tương ứng)

-

Metadata của trace (số lượng token đầu vào và đầu ra, chi phí, mô hình, loại Agent)

-

Các chỉ số đánh giá (bao gồm các chỉ số RAG và chuỗi suy luận – chain-of-thought)

Ảnh chụp màn hình tiếp theo hiển thị trace của câu hỏi Text-to-SQL (question ID 4) trong quá trình đánh giá trên Langfuse. Đây là đánh giá dành cho Agent phân tích cơ sở dữ liệu dấu ấn sinh học, người có nhiệm vụ tạo truy vấn SQL để thực thi trên cơ sở dữ liệu Amazon Redshift chứa thông tin về các dấu ấn sinh học.

Ảnh chụp màn hình hiển thị các thông tin sau:

-

Thông tin trace (đầu vào và đầu ra của lần gọi Agent)

-

Các bước trace (quá trình sinh nội dung của Agent và các bước con tương ứng)

-

Metadata của trace (số lượng token đầu vào và đầu ra, chi phí, mô hình, loại Agent)

-

Các chỉ số đánh giá (bao gồm các chỉ số Text-to-SQL và chuỗi suy luận – chain-of-thought)

Đánh giá chuỗi suy luận (chain-of-thought) được bao gồm trong trace đánh giá của cả hai câu hỏi. Với cả hai trace này, phương pháp LLM-as-a-judge được sử dụng để tạo ra điểm số và giải thích về khả năng lập luận của Amazon Bedrock Agent cho từng câu hỏi cụ thể.

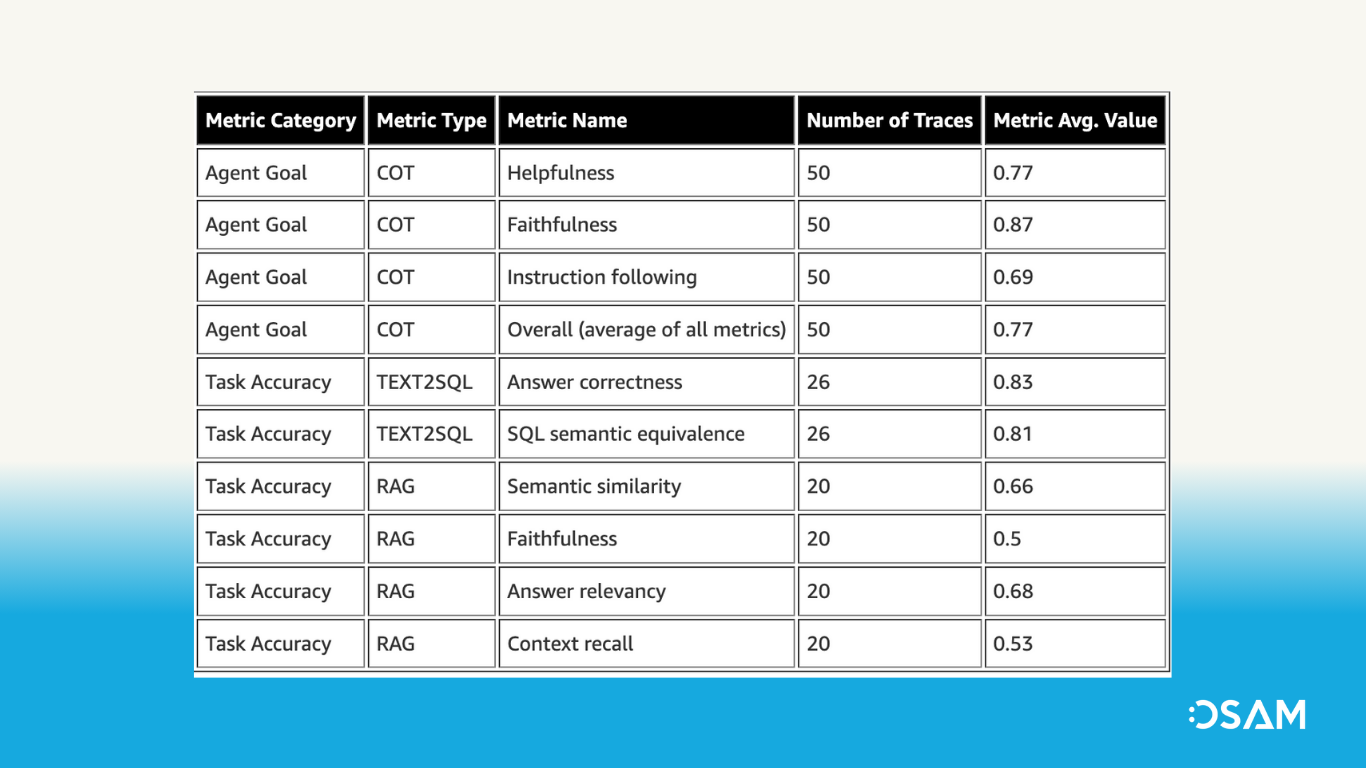

Tổng cộng, chúng tôi đã thực hiện đánh giá 56 câu hỏi, được nhóm thành 21 trajectory, đối với Agent. Các trace, chi phí mô hình và điểm số được thể hiện trong ảnh chụp màn hình sau.

Bảng sau đây trình bày điểm đánh giá trung bình được tính trên 56 trace đánh giá.

Cân nhắc về bảo mật

Hãy lưu ý các biện pháp bảo mật sau:

-

Bật ghi nhật ký Agent của Amazon Bedrock – Để thực hiện các phương pháp bảo mật tốt nhất khi sử dụng Amazon Bedrock Agents, hãy bật ghi nhật ký gọi mô hình của Amazon Bedrock để lưu trữ an toàn các prompt và phản hồi trong tài khoản của bạn.

-

Kiểm tra các yêu cầu tuân thủ – Trước khi triển khai Amazon Bedrock Agents trong môi trường sản xuất, hãy đảm bảo rằng các chứng nhận và tiêu chuẩn tuân thủ của Amazon Bedrock phù hợp với yêu cầu quy định của bạn. Tham khảo mục Xác thực tuân thủ cho Amazon Bedrock để biết thêm thông tin và tài nguyên liên quan.

Dọn dẹp

Nếu bạn đã triển khai các Agents mẫu, hãy chạy các notebook sau để xóa các tài nguyên đã tạo.

Nếu bạn chọn sử dụng phiên bản Langfuse tự lưu trữ, hãy làm theo các bước sau để dọn dẹp thiết lập Langfuse trên AWS của bạn.

Kết luận

Trong bài viết này, chúng tôi đã giới thiệu Open Source Bedrock Agent Evaluation, một giải pháp tích hợp với Langfuse giúp đơn giản hóa quá trình phát triển Agents. Framework này được trang bị logic đánh giá sẵn cho các tác vụ như RAG, text-to-SQL, suy luận theo chuỗi tư duy (chain-of-thought), và tích hợp với Langfuse để hiển thị các chỉ số đánh giá.

Với Open Source Bedrock Agent Evaluation, các nhà phát triển có thể nhanh chóng đánh giá Agents của mình và thử nghiệm các cấu hình khác nhau, từ đó rút ngắn chu kỳ phát triển và cải thiện hiệu suất.

Chúng tôi cũng đã trình bày cách tích hợp framework đánh giá này với Agents nghiên cứu dược phẩm, đánh giá hiệu quả của các Agents khi trả lời câu hỏi liên quan đến biomarker, và gửi các trace đến Langfuse để theo dõi chỉ số đánh giá cho từng loại câu hỏi.

Open Source Bedrock Agent Evaluation giúp bạn tăng tốc quá trình xây dựng ứng dụng AI sinh ngữ sử dụng Amazon Bedrock Agents. Để tự lưu trữ Langfuse trên tài khoản AWS của bạn, hãy xem hướng dẫn Hosting Langfuse on Amazon ECS with Fargate using CDK Python.

Để khám phá cách tinh giản quy trình đánh giá Amazon Bedrock Agents của bạn, hãy bắt đầu với Open Source Bedrock Agent Evaluation.

Tham khảo bài viết Towards Effective GenAI Multi-Agent Collaboration: Design and Evaluation for Enterprise Applications từ nhóm Amazon Bedrock để tìm hiểu thêm về hợp tác đa-Agent và quy trình đánh giá end-to-end.

Nguồn bài viết: https://aws.amazon.com/vi/blogs/machine-learning/evaluate-amazon-bedrock-agents-with-ragas-and-llm-as-a-judge/

Tìm hiểu thêm về AWS: https://aws.amazon.com/vi/blogs/apn/bringing-the-power-of-aws-generative-ai-to-infors-industry-first-approach/