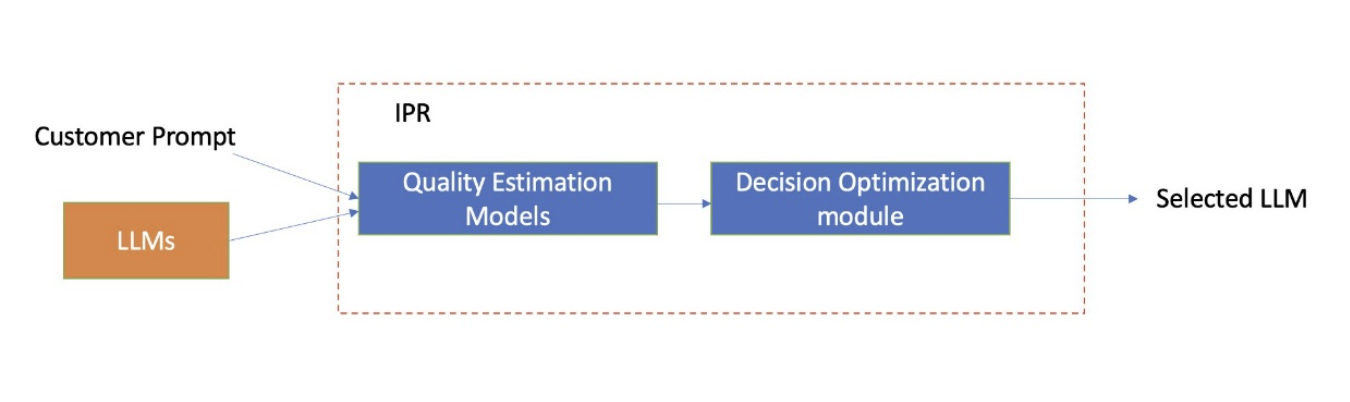

Vào tháng 12, AWS đã công bố bản xem trước khả dụng cho Amazon Bedrock Intelligent Prompt Routing, cung cấp một điểm cuối không có máy chủ duy nhất để định tuyến hiệu quả các yêu cầu giữa các mô hình nền tảng khác nhau trong cùng một họ mô hình. Để thực hiện điều này, Amazon Bedrock Intelligent Prompt Routing dự đoán động chất lượng phản hồi của từng mô hình cho một yêu cầu và định tuyến yêu cầu đến mô hình mà nó xác định là phù hợp nhất dựa trên chi phí và chất lượng phản hồi, như thể hiện trong hình sau.

Hôm nay, chúng tôi rất vui mừng thông báo về việc ra mắt chính thức tính năng Định tuyến Prompt Thông minh (Intelligent Prompt Routing) của Amazon Bedrock.

Trong vài tháng qua, Amazon đã thực hiện nhiều cải tiến cho tính năng định tuyến prompt thông minh, dựa trên phản hồi từ khách hàng và quá trình kiểm thử nội bộ chuyên sâu. Mục tiêu của chúng tôi là giúp bạn dễ dàng thiết lập quy trình định tuyến tự động và tối ưu giữa các mô hình ngôn ngữ lớn (LLMs), thông qua tính năng Định tuyến Prompt Thông minh của Amazon Bedrock — tính năng này hiểu sâu sắc hành vi của từng họ mô hình, và ứng dụng các phương pháp tiên tiến nhất để huấn luyện bộ định tuyến phù hợp với từng nhóm mô hình, tác vụ và prompt.

Trong bài viết blog này, OSAM sẽ nêu bật các kết quả nổi bật từ quá trình kiểm thử nội bộ, hướng dẫn bạn cách bắt đầu sử dụng tính năng này, đồng thời chia sẻ một số lưu ý và thực tiễn tốt nhất.

Chúng tôi khuyến khích bạn tích hợp tính năng Định tuyến Prompt Thông minh của Amazon Bedrock vào các ứng dụng AI tạo sinh mới và hiện có của mình.

Những điểm nổi bật và cải tiến

Hiện tại, bạn có thể sử dụng Định tuyến Prompt Thông minh của Amazon Bedrock theo hai cách:

- Sử dụng trình định tuyến prompt mặc định do Amazon Bedrock cung cấp, hoặc

- Tùy chỉnh trình định tuyến prompt của riêng bạn để cân bằng hiệu suất giữa hai mô hình ngôn ngữ lớn (LLM) theo nhu cầu.

Trình định tuyến prompt mặc định là các hệ thống định tuyến được cấu hình sẵn, có khả năng điều hướng yêu cầu đến mô hình có hiệu suất cao hơn trong số hai mô hình, đồng thời tiết kiệm chi phí bằng cách chuyển các prompt đơn giản hơn đến mô hình rẻ hơn. Amazon Bedrock cung cấp các trình định tuyến này cho từng họ mô hình, với các thiết lập định sẵn và sẵn sàng hoạt động ngay mà không cần cấu hình thêm.

Trong giai đoạn dùng thử, các khách hàng (AWS xin cảm ơn!) đã có thể lựa chọn các mô hình thuộc họ Anthropic và Meta. Đến thời điểm phát hành chính thức (GA), người dùng có thể lựa chọn nhiều mô hình hơn từ các họ Amazon Nova, Anthropic, và Meta, bao gồm:

- Họ Claude của Anthropic: Haiku, Sonnet 3.5 v1, Haiku 3.5, Sonnet 3.5 v2

- Họ Llama: Llama 3.1 8B, 70B, 3.2 11B, 90B và 3.3 70B

- Họ Nova: Nova Pro và Nova Lite

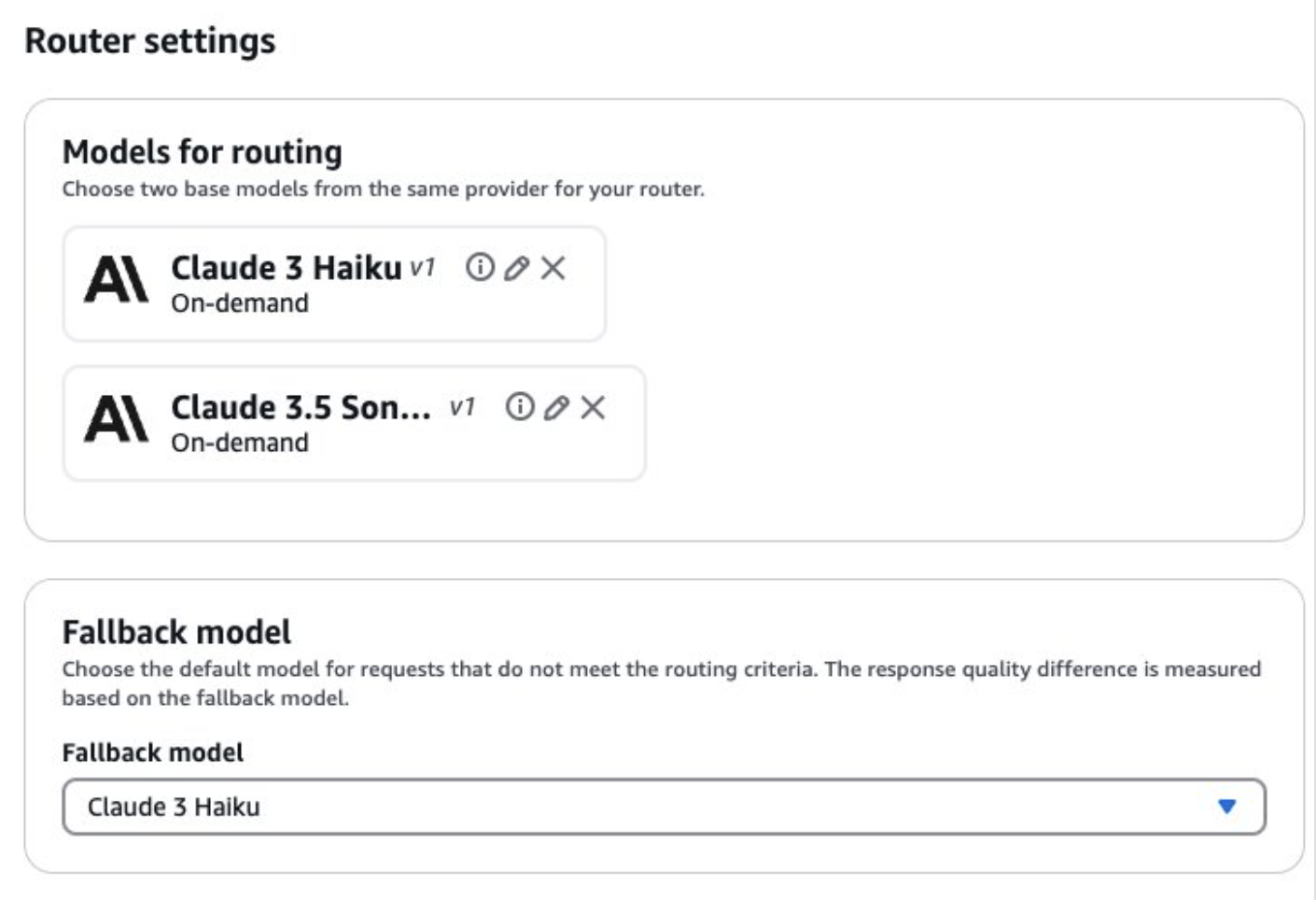

Bạn cũng có thể tùy chỉnh trình định tuyến prompt theo nhu cầu riêng bằng cách chọn hai mô hình bất kỳ trong cùng một họ và cấu hình mức độ chênh lệch chất lượng phản hồi theo mong muốn. Tùy chọn này phù hợp với những ai cần kiểm soát chặt chẽ hơn việc định tuyến và lựa chọn mô hình.

Việc thêm các thành phần xử lý trước khi gửi prompt đến mô hình LLM được chọn có thể gây ra độ trễ bổ sung. Tuy nhiên, AWS đã giảm độ trễ do thành phần thêm vào hơn 20%, còn khoảng 85 mili giây ở ngưỡng P90. Nhờ cơ chế ưu tiên gọi các mô hình có chi phí thấp hơn mà vẫn duy trì độ chính xác cơ bản, bạn có thể đạt được lợi ích về chi phí và độ trễ, thay vì luôn sử dụng mô hình lớn và tốn kém hơn — ngay cả khi có thêm một chút overhead. Phần tiếp theo về kết quả benchmark sẽ làm rõ hơn vấn đề này.

AWS đã thực hiện nhiều thử nghiệm nội bộ với cả dữ liệu công khai và dữ liệu độc quyền để đánh giá các chỉ số của tính năng Định tuyến Prompt Thông minh. Cụ thể:

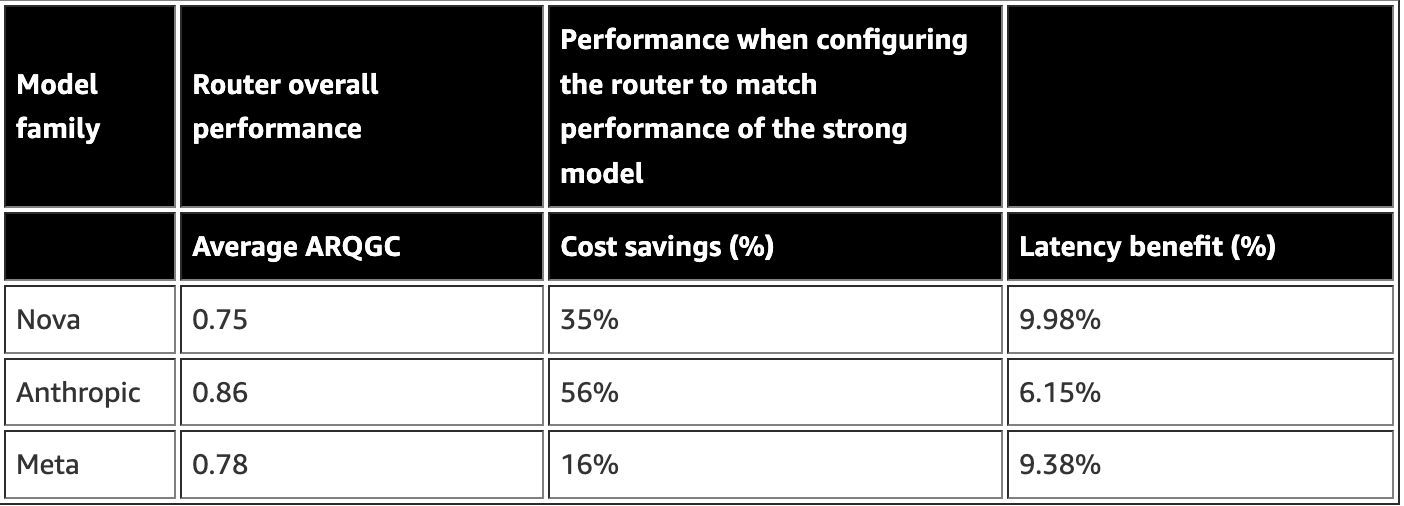

- AWS sử dụng chỉ số ARQGC (Average Response Quality Gain under Cost Constraints) — một thước đo hiệu suất đã chuẩn hóa (0–1) để đánh giá chất lượng hệ thống định tuyến trong các điều kiện chi phí khác nhau, tham chiếu theo mô hình đánh giá phần thưởng. Trong đó, 0.5 đại diện cho định tuyến ngẫu nhiên và 1 đại diện cho hiệu suất định tuyến tối ưu theo chuẩn “oracle”.

- Đồng thời, AWS ghi nhận mức tiết kiệm chi phí so với việc luôn sử dụng mô hình lớn nhất trong họ mô hình, và ước tính lợi ích về độ trễ dựa trên thời gian trung bình để nhận token đầu tiên (TTFT) — các chỉ số này được trình bày chi tiết trong bảng kết quả sau.

Cách đọc bảng này?

Trước hết, điều quan trọng là phải dừng lại và hiểu rõ các chỉ số trong bảng.

- Kết quả trong bảng chỉ mang tính so sánh với phương pháp định tuyến ngẫu nhiên trong cùng một họ mô hình (tức là cải thiện chỉ số ARQGC so với mức 0.5), không nên dùng để so sánh giữa các họ mô hình khác nhau.

- Kết quả chỉ có ý nghĩa trong phạm vi từng họ mô hình, và khác biệt hoàn toàn với các bảng đánh giá mô hình mà bạn có thể đã quen dùng để so sánh hiệu suất giữa các mô hình LLM.

Vì chi phí thực tế và giá thành có thể thay đổi thường xuyên, đồng thời phụ thuộc vào số lượng token đầu vào và đầu ra, nên rất khó để so sánh chi phí thực một cách chính xác.

Để giải quyết vấn đề này, AWS đã định nghĩa chỉ số tiết kiệm chi phí là mức chi phí tối đa có thể tiết kiệm được so với việc luôn sử dụng mô hình LLM mạnh nhất, trong khi vẫn đạt được một mức chất lượng phản hồi nhất định.

Ví dụ: trong bảng minh họa, người dùng có thể tiết kiệm trung bình 35% chi phí khi sử dụng trình định tuyến của họ Nova, so với việc luôn dùng Nova Pro cho mọi prompt mà không có định tuyến thông minh.

Tùy vào từng trường hợp sử dụng cụ thể, mức độ lợi ích mà bạn nhận được sẽ khác nhau. Ví dụ, trong một bài kiểm thử nội bộ với hàng trăm prompt, AWS đạt được mức tiết kiệm chi phí lên tới 60% khi sử dụng Định tuyến Prompt Thông minh của Amazon Bedrock với họ mô hình Anthropic, trong khi chất lượng phản hồi vẫn tương đương với Claude Sonnet 3.5 V2.

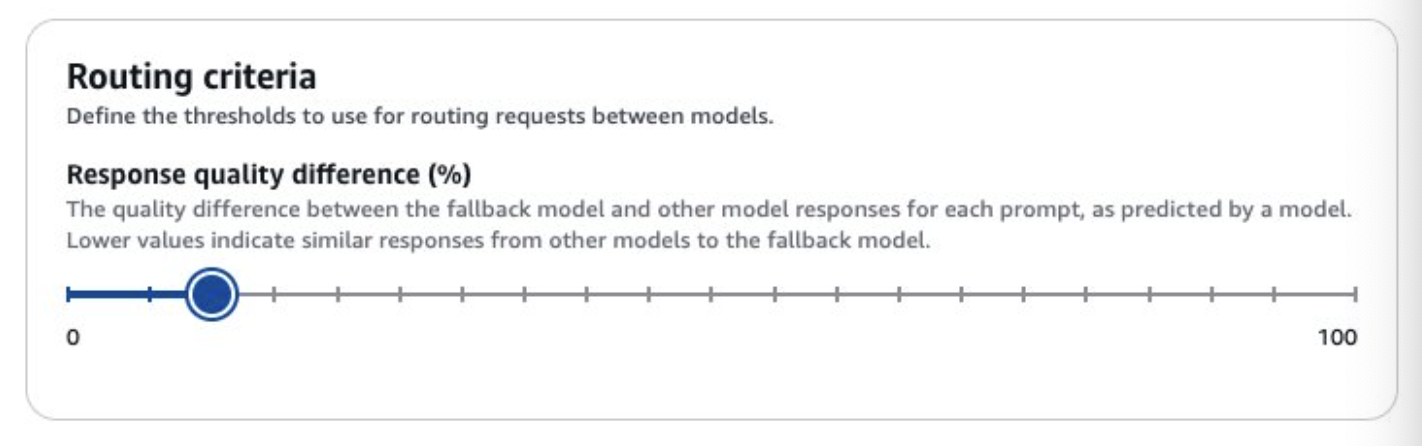

Chỉ số chênh lệch chất lượng phản hồi là gì?

Chênh lệch chất lượng phản hồi đo lường mức độ khác biệt giữa phản hồi của mô hình dự phòng (fallback) và các mô hình khác.

- Giá trị nhỏ cho thấy các phản hồi có chất lượng tương tự nhau.

- Giá trị lớn hơn cho thấy có sự khác biệt đáng kể giữa phản hồi của mô hình dự phòng và các mô hình còn lại.

Việc chọn mô hình nào làm mô hình dự phòng là rất quan trọng.

Ví dụ: khi cấu hình chênh lệch chất lượng phản hồi là 10%, với Claude 3 Sonnet của Anthropic là mô hình dự phòng, thì trình định tuyến sẽ tự động chọn mô hình sao cho tổng thể phản hồi chỉ giảm tối đa 10% so với Claude 3 Sonnet.

Ngược lại, nếu bạn dùng Claude 3 Haiku (mô hình rẻ hơn) làm mô hình dự phòng, thì trình định tuyến sẽ tìm cách chọn mô hình sao cho phản hồi tổng thể tăng ít nhất 10% so với Haiku.

Trong hình minh họa tiếp theo, bạn sẽ thấy giá trị chênh lệch chất lượng phản hồi được đặt ở mức 10%, với Haiku là mô hình dự phòng.

Nếu bạn muốn khám phá các cấu hình tối ưu ngoài thiết lập mặc định, bạn có thể:

- Thử nghiệm các ngưỡng khác nhau cho chỉ số chênh lệch chất lượng phản hồi

- Phân tích chất lượng phản hồi, chi phí và độ trễ của trình định tuyến dựa trên bộ dữ liệu phát triển của bạn

- Và chọn ra cấu hình phù hợp nhất với yêu cầu ứng dụng.

Khi tự cấu hình trình định tuyến prompt, bạn có thể thiết lập ngưỡng chênh lệch chất lượng phản hồi (%) trong giao diện Configure prompt router của Amazon Bedrock Console. Nếu bạn muốn thực hiện việc này bằng API, vui lòng tham khảo phần “How to use intelligent prompt routing” trong tài liệu kỹ thuật.

Kết quả kiểm thử hiệu năng (Benchmark results)

Khi sử dụng các cặp mô hình khác nhau, khả năng của mô hình nhỏ hơn trong việc xử lý một số lượng lớn các prompt đầu vào có thể mang lại lợi ích rõ rệt về độ trễ và chi phí, tùy thuộc vào lựa chọn mô hình và mục đích sử dụng cụ thể.

Ví dụ: khi so sánh việc sử dụng Claude 3 Haiku và Claude 3.5 Haiku kết hợp với Claude 3.5 Sonnet, AWS ghi nhận kết quả sau từ một tập dữ liệu nội bộ:

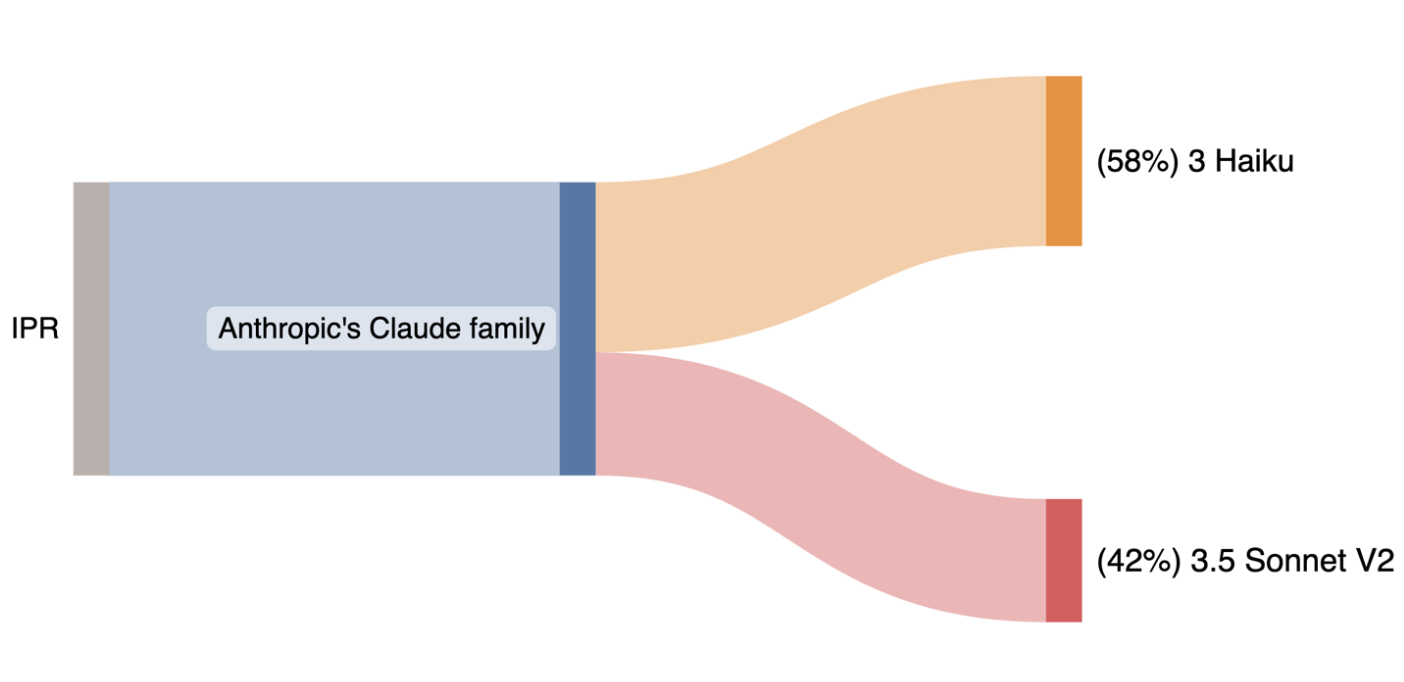

Trường hợp 1: Định tuyến giữa Claude 3 Haiku và Claude 3.5 Sonnet V2

→ Tiết kiệm chi phí lên đến 48%

→ Trong khi vẫn duy trì chất lượng phản hồi ngang bằng với Claude 3.5 Sonnet V2

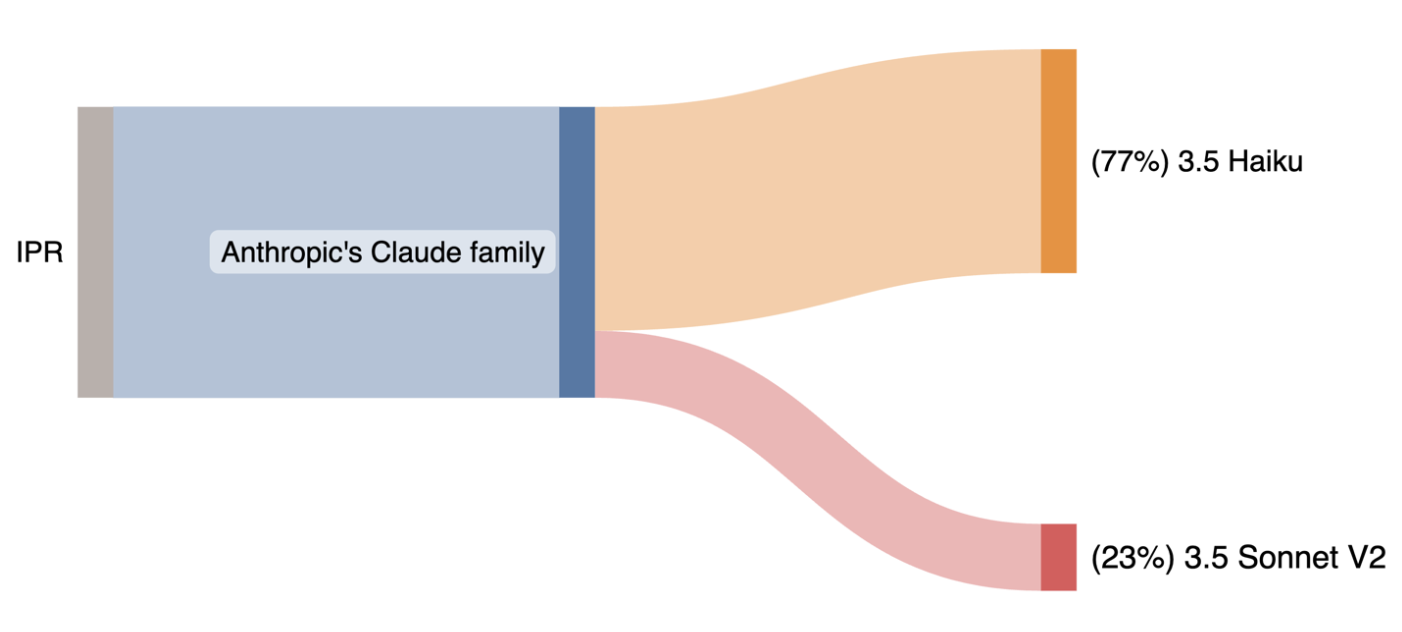

Trường hợp 2: Định tuyến giữa Claude 3.5 Haiku và Claude 3.5 Sonnet V2

→ Tiết kiệm chi phí lên đến 56%

→ Trong khi vẫn duy trì chất lượng phản hồi ngang bằng với Claude 3.5 Sonnet V2

Như bạn có thể thấy trong Trường hợp 1 và Trường hợp 2, khi năng lực của các mô hình có chi phí thấp hơn được cải thiện so với các mô hình đắt hơn trong cùng một họ (ví dụ: từ Claude 3 Haiku đến Claude 3.5 Haiku), bạn có thể kỳ vọng các tác vụ phức tạp hơn sẽ được xử lý một cách đáng tin cậy bởi các mô hình rẻ hơn. Do đó, tỷ lệ định tuyến đến mô hình chi phí thấp sẽ tăng lên, trong khi vẫn duy trì độ chính xác tổng thể tương đương.

AWS khuyến khích bạn kiểm thử tính hiệu quả của Amazon Bedrock Intelligent Prompt Routing trên chính các tác vụ chuyên biệt và lĩnh vực dữ liệu của mình, vì kết quả có thể khác nhau tùy theo từng trường hợp sử dụng.

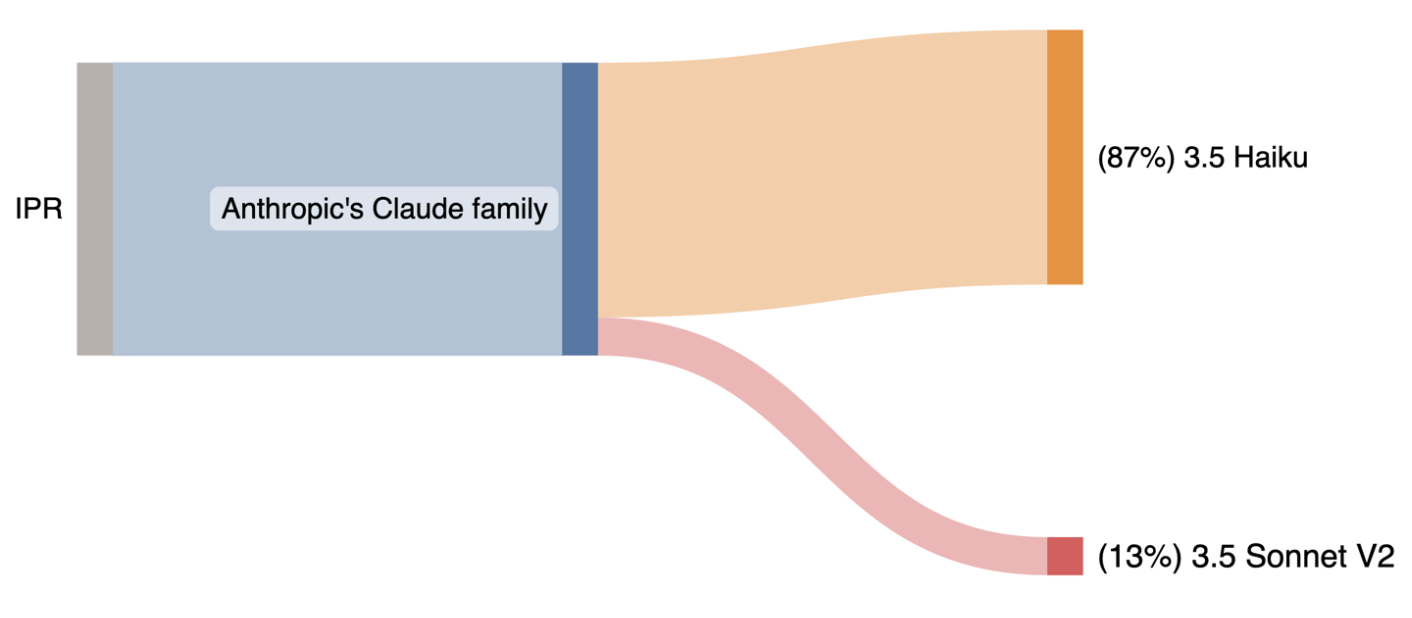

Ví dụ: khi AWS kiểm thử Amazon Bedrock Intelligent Prompt Routing với các tập dữ liệu RAG (Retrieval Augmented Generation) mã nguồn mở và nội bộ, đạt mức tiết kiệm chi phí trung bình lên tới 63.6%.

→ Điều này là nhờ có 87% prompt được định tuyến đến Claude 3.5 Haiku, trong khi vẫn duy trì độ chính xác tương đương với việc chỉ sử dụng mô hình lớn hơn/đắt hơn (Claude Sonnet 3.5 V2 – như minh họa trong hình dưới), tính trung bình trên các tập dữ liệu RAG.

Bắt đầu sử dụng

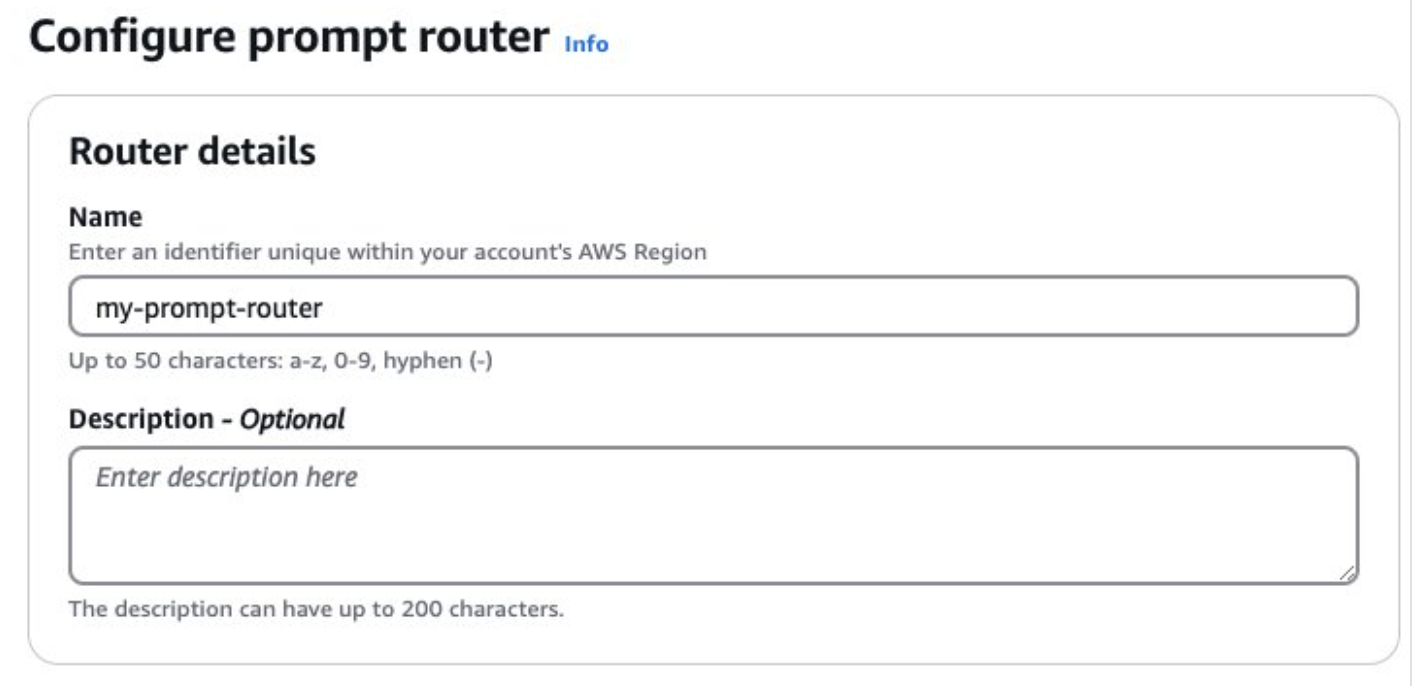

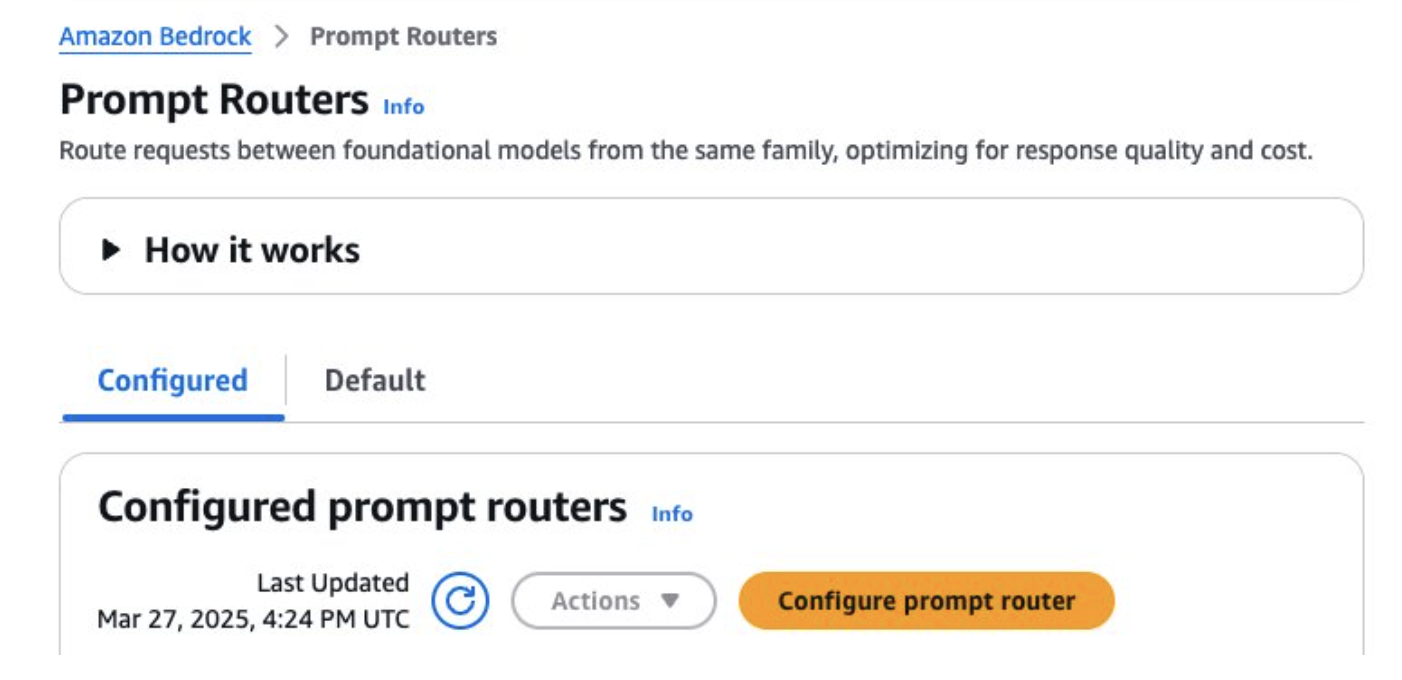

Bạn có thể bắt đầu sử dụng Amazon Bedrock thông qua AWS Management Console. Như đã đề cập trước đó, bạn có thể tạo router của riêng mình hoặc sử dụng router mặc định:

Sử dụng bảng điều khiển (console) để cấu hình router:

Trong Amazon Bedrock Console, chọn Prompt Routers ở thanh điều hướng bên trái. Sau đó, chọn Configure prompt router (Cấu hình bộ định tuyến prompt).

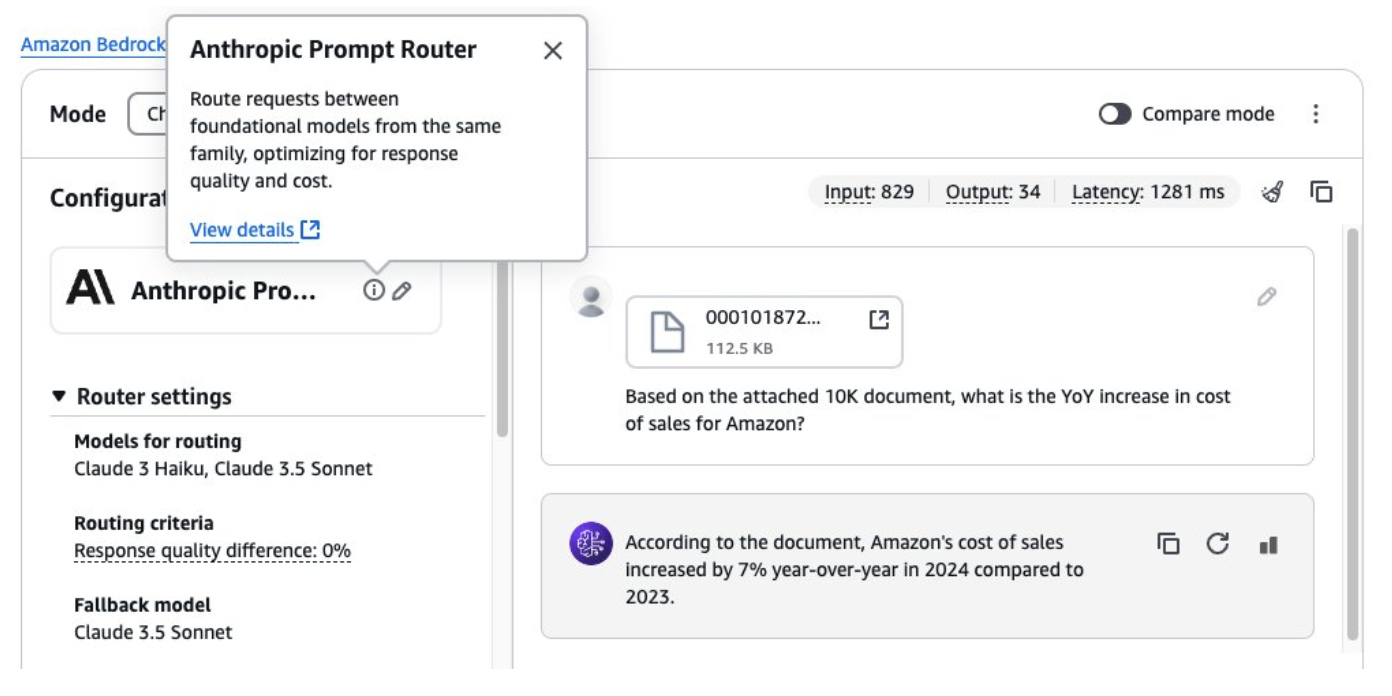

- Sau đó, bạn có thể sử dụng router đã được cấu hình trước hoặc router mặc định trong môi trường thử nghiệm (console-based playground). Ví dụ, trong hình dưới đây, chúng tôi đã đính kèm một tài liệu 10K từ Amazon.com và đặt một câu hỏi cụ thể về chi phí bán hàng.

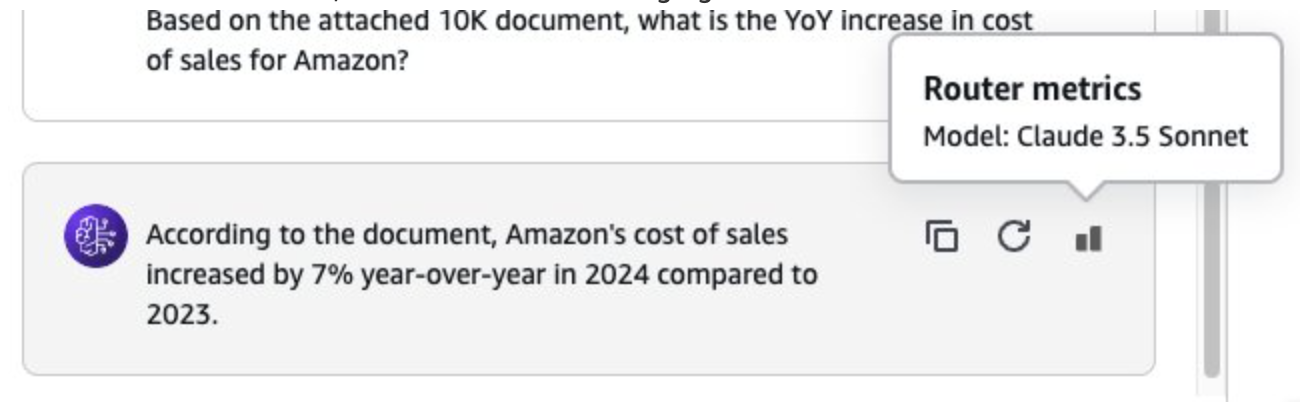

- Chọn biểu tượng metrics của router (nằm cạnh biểu tượng làm mới) để xem mô hình mà yêu cầu đã được định tuyến đến. Vì đây là một câu hỏi có tính chất tinh vi, Amazon Bedrock Intelligent Prompt Routing đã định tuyến đúng đến Claude 3.5 Sonnet V2 trong trường hợp này, như được minh họa trong hình dưới đây.

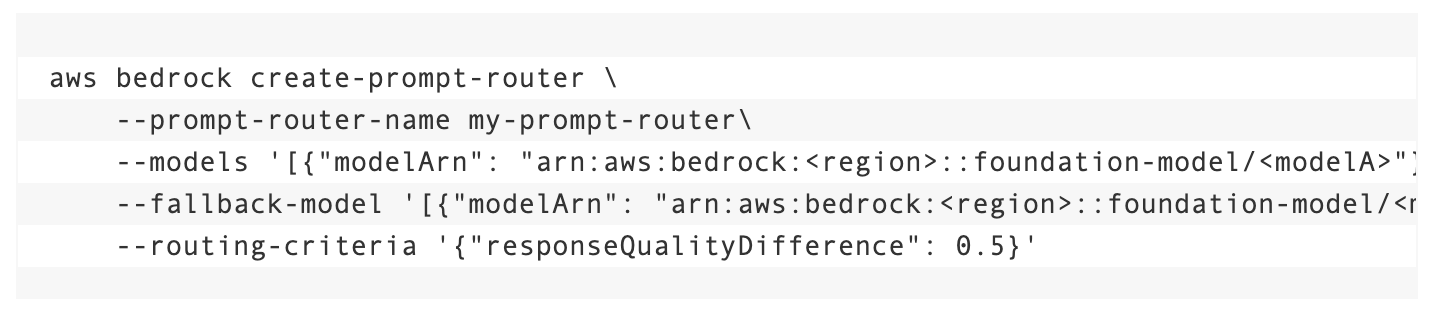

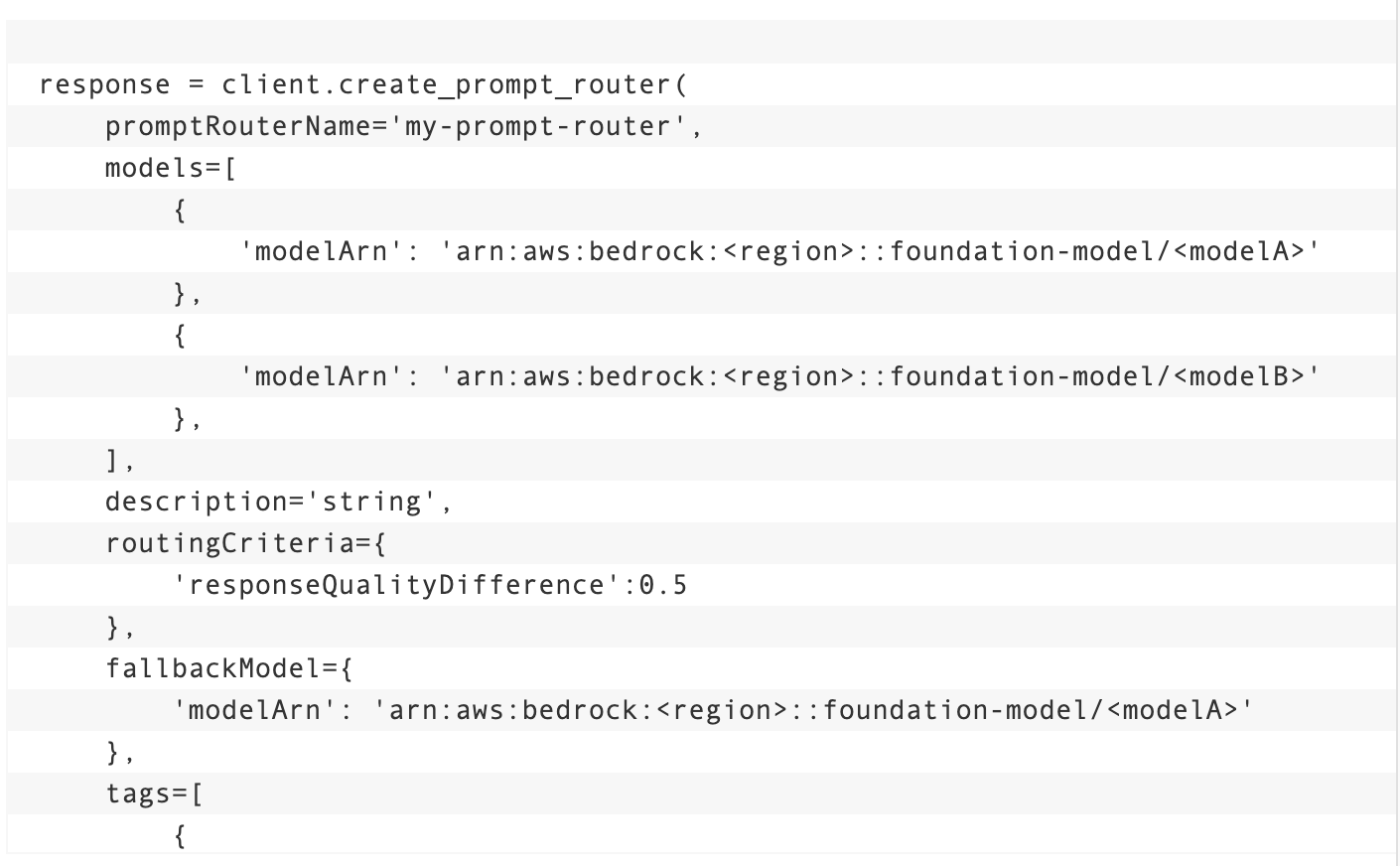

Bạn cũng có thể sử dụng AWS Command Line Interface (AWS CLI) hoặc API để cấu hình và sử dụng bộ định tuyến prompt.

Để sử dụng AWS CLI hoặc API để cấu hình bộ định tuyến:

AWS CLI:

Bộ phát triển Boto3:

Những lưu ý và thực tiễn tốt nhất

Khi sử dụng Amazon Bedrock Intelligent Prompt Routing, hãy lưu ý rằng:

- Amazon Bedrock Intelligent Prompt Routing được tối ưu hóa cho các prompt tiếng Anh trong các trường hợp sử dụng trợ lý trò chuyện điển hình. Đối với việc sử dụng với các ngôn ngữ khác hoặc các trường hợp sử dụng tùy chỉnh, hãy tiến hành kiểm thử riêng trước khi triển khai định tuyến prompt vào các ứng dụng sản xuất, hoặc liên hệ với nhóm AWS account của bạn để được hỗ trợ thiết kế và thực hiện các bài kiểm thử này.

- Bạn chỉ có thể chọn hai mô hình để tham gia vào bộ định tuyến (định tuyến theo cặp), với một trong hai mô hình này là mô hình dự phòng. Hai mô hình này phải nằm trong cùng một AWS Region.

- Khi bắt đầu với Amazon Bedrock Intelligent Prompt Routing, chúng tôi khuyến nghị bạn thử nghiệm sử dụng các router mặc định do Amazon Bedrock cung cấp trước khi thử cấu hình các router tùy chỉnh. Sau khi đã thử nghiệm với các router mặc định, bạn có thể cấu hình các router riêng của mình theo yêu cầu cho các trường hợp sử dụng, đánh giá chất lượng phản hồi trong môi trường thử nghiệm, và sử dụng chúng cho các ứng dụng sản xuất nếu đáp ứng được yêu cầu của bạn.

- Amazon Bedrock Intelligent Prompt Routing hiện không thể điều chỉnh quyết định định tuyến hoặc phản hồi dựa trên dữ liệu hiệu suất cụ thể của ứng dụng và có thể không luôn cung cấp định tuyến tối ưu nhất cho các trường hợp sử dụng đặc biệt hoặc theo lĩnh vực chuyên môn. Liên hệ với nhóm AWS account của bạn để được hỗ trợ tùy chỉnh cho các trường hợp sử dụng cụ thể.

Kết luận

Trong bài viết này, chúng tôi đã khám phá Amazon Bedrock Intelligent Prompt Routing, nhấn mạnh khả năng giúp tối ưu hóa cả chất lượng phản hồi và chi phí bằng cách định tuyến động các yêu cầu giữa các mô hình nền tảng khác nhau. Các kết quả benchmark chứng minh việc tiết kiệm chi phí đáng kể trong khi vẫn duy trì chất lượng phản hồi cao và lợi ích giảm độ trễ giữa các họ mô hình. Dù bạn triển khai các router mặc định đã được cấu hình trước hay tạo các cấu hình tùy chỉnh, Amazon Bedrock Intelligent Prompt Routing mang đến một cách mạnh mẽ để cân bằng giữa hiệu suất và hiệu quả trong các ứng dụng AI sáng tạo. Khi triển khai tính năng này trong quy trình làm việc của mình, chúng tôi khuyến nghị bạn kiểm thử tính hiệu quả của nó cho các trường hợp sử dụng cụ thể để tận dụng tối đa tính linh hoạt mà nó mang lại. Để bắt đầu, hãy tham khảo Hiểu về định tuyến prompt thông minh trong Amazon Bedrock.

Tìm hiểu thêm: https://osam.io/danh-gia-amazon-bedrock-agents-ragas-mo-hinh-ngon-ngu-lon/