AI Agents đang nhanh chóng trở thành biên giới mới trong chuyển đổi doanh nghiệp, với 82% tổ chức có kế hoạch áp dụng trong vòng 3 năm tới. Theo một khảo sát của Capgemini với 1.100 giám đốc điều hành tại các doanh nghiệp lớn, 10% tổ chức đã sử dụng AI Agents và hơn một nửa dự định triển khai trong năm tới. Việc ra mắt các mô hình DeepSeek-R1 gần đây mang lại khả năng suy luận tiên tiến cho cộng đồng mã nguồn mở. Các tổ chức có thể xây dựng ứng dụng AI Agents sử dụng các mô hình suy luận này để thực hiện nhiệm vụ phức tạp với khả năng ra quyết định nâng cao, giúp tăng cường hiệu suất và khả năng thích ứng.

Trong bài viết này, chúng tôi sẽ khám phá cách các tổ chức có thể sử dụng Amazon SageMaker AI, một dịch vụ được quản lý hoàn toàn cho phép xây dựng, huấn luyện và triển khai mô hình ML ở quy mô lớn, đồng thời tạo AI Agents bằng CrewAI, một framework agentic phổ biến, cùng với các mô hình mã nguồn mở như DeepSeek-R1.

Tìm hiểu thêm: https://osam.io/deepseek-r1-hien-co-the-trien-khai-tren-aws/

Thiết kế Agentic vs Phần mềm Truyền thống

Hệ thống Agentic cung cấp một cách tiếp cận hoàn toàn khác so với phần mềm truyền thống, đặc biệt trong việc xử lý các thách thức phức tạp, động và chuyên biệt theo từng lĩnh vực. Khác với các hệ thống truyền thống dựa trên tự động hóa theo quy tắc và dữ liệu có cấu trúc, hệ thống Agentic, được hỗ trợ bởi các Large Language Models (LLMs), có thể hoạt động tự động, học hỏi từ môi trường và đưa ra quyết định tinh vi dựa trên ngữ cảnh. Điều này được thực hiện thông qua các thành phần mô-đun như suy luận, bộ nhớ, kỹ năng nhận thức và công cụ, giúp chúng thực hiện các nhiệm vụ phức tạp và thích ứng với các tình huống thay đổi.

Các nền tảng phần mềm truyền thống, dù hiệu quả trong việc xử lý các tác vụ lặp lại và mở rộng theo chiều ngang, thường thiếu trí tuệ chuyên biệt theo lĩnh vực và khả năng linh hoạt mà hệ thống Agentic cung cấp. Ví dụ, trong ngành sản xuất, hệ thống truyền thống có thể theo dõi hàng tồn kho nhưng không thể dự đoán gián đoạn chuỗi cung ứng hoặc tối ưu hóa việc mua sắm dựa trên dữ liệu thị trường theo thời gian thực. Ngược lại, một hệ thống Agentic có thể xử lý dữ liệu trực tiếp như biến động hàng tồn kho, sở thích khách hàng và các yếu tố môi trường để chủ động điều chỉnh chiến lược và định tuyến lại chuỗi cung ứng khi có gián đoạn.

Các doanh nghiệp nên xem xét triển khai hệ thống Agentic trong các tình huống yêu cầu tính thích ứng cao và chuyên môn theo lĩnh vực. Ví dụ, trong dịch vụ khách hàng, chatbot truyền thống bị giới hạn trong các phản hồi được lập trình sẵn cho những câu hỏi dự đoán trước, trong khi AI Agents có thể giao tiếp bằng ngôn ngữ tự nhiên, cung cấp hỗ trợ cá nhân hóa và giải quyết yêu cầu hiệu quả hơn. AI Agents còn giúp nâng cao năng suất bằng cách tự động hóa các tác vụ lặp lại như tạo báo cáo, viết email và lập trình phần mềm.

Việc triển khai hệ thống Agentic nên tập trung vào các quy trình được xác định rõ ràng với tiêu chí thành công cụ thể, đồng thời tận dụng khả năng linh hoạt và giảm thiểu sự cứng nhắc trong quản lý quy trình.

DeepSeek-R1

Trong bài viết này, chúng tôi hướng dẫn bạn cách triển khai DeepSeek-R1 trên SageMaker, đặc biệt là phiên bản rút gọn Llama-70B, DeepSeek-R1-Distill-Llama-70B, tới một SageMaker real-time endpoint. DeepSeek-R1 là một LLM tiên tiến do startup DeepSeek phát triển, sử dụng các kỹ thuật học tăng cường (reinforcement learning) để nâng cao khả năng suy luận, giúp thực hiện các nhiệm vụ phức tạp như giải toán và lập trình.

Để tìm hiểu thêm về DeepSeek-R1, hãy tham khảo bài viết DeepSeek-R1 model now available in Amazon Bedrock Marketplace and Amazon SageMaker JumpStart và khám phá luận điểm đằng sau việc xây dựng DeepSeek-R1.

Tìm hiểu thêm: https://github.com/deepseek-ai/DeepSeek-R1

Generative AI trên SageMaker AI

Trong bài viết này, chúng tôi hướng dẫn bạn cách triển khai DeepSeek-R1 trên SageMaker, đặc biệt là phiên bản rút gọn Llama-70B, DeepSeek-R1-Distill-Llama-70B, tới một SageMaker real-time endpoint. DeepSeek-R1 là một LLM tiên tiến do startup DeepSeek phát triển, sử dụng các kỹ thuật học tăng cường (reinforcement learning) để nâng cao khả năng suy luận, giúp thực hiện các nhiệm vụ phức tạp như giải toán và lập trình.

Để tìm hiểu thêm về DeepSeek-R1, hãy tham khảo bài viết DeepSeek-R1 model now available in Amazon Bedrock Marketplace and Amazon SageMaker JumpStart và khám phá luận điểm đằng sau việc xây dựng DeepSeek-R1.

SageMaker AI đơn giản hóa quy trình cho các nhà phát triển mô hình Generative AI ở mọi cấp độ kỹ năng khi làm việc với Foundation Models (FMs):

Amazon SageMaker Canvas cho phép các nhà khoa học dữ liệu dễ dàng sử dụng tập dữ liệu riêng của họ kết hợp với FMs để tạo ứng dụng và kiến trúc như chatbots và Retrieval-Augmented Generation (RAG) trong môi trường low-code hoặc no-code.

Amazon SageMaker JumpStart cung cấp nhiều mô hình FMs mã nguồn mở và độc quyền từ các nhà cung cấp như Hugging Face, Meta, Stability AI. Người dùng có thể triển khai hoặc tinh chỉnh mô hình thông qua giao diện trực quan hoặc APIs, giúp linh hoạt cho mọi cấp độ kỹ năng.

SageMaker AI cung cấp các tính năng như notebooks, Amazon SageMaker Training, inference, SageMaker for MLOps và Partner AI Apps, cho phép các nhà phát triển mô hình nâng cao tinh chỉnh FMs bằng LoRA, fine-tuning toàn phần hoặc huấn luyện từ đầu. Hệ thống hỗ trợ từ single GPU đến HyperPods (cụm GPU), kèm theo công cụ FMOps để theo dõi, gỡ lỗi và triển khai.

Với SageMaker AI, bạn có thể xây dựng agentic workflows tích hợp Generative AI bằng framework tùy chọn. Một số lợi ích chính khi sử dụng SageMaker AI để tinh chỉnh và lưu trữ LLMs hoặc FMs bao gồm:

- Dễ dàng triển khai

SageMaker AI cung cấp quyền truy cập vào SageMaker JumpStart, một hub mô hình với trọng số mở, giúp triển khai chỉ với vài cú nhấp chuột hoặc API call.

Đối với các mô hình từ Hugging Face Hub, SageMaker AI hỗ trợ các container tối ưu hóa sẵn, dựa trên các framework mã nguồn mở phổ biến như vLLM, NVIDIA Triton, Hugging Face Text Generation Inference (TGI). Chỉ cần chỉ định model ID, bạn có thể triển khai mô hình ngay lập tức.

- Mô hình định giá dựa trên instance

Các mô hình lưu trữ trên SageMaker AI được tính phí dựa trên instance-hours, thay vì token usage. Điều này giúp dự đoán và quản lý chi phí suy luận chính xác hơn trong khi vẫn đảm bảo khả năng mở rộng tài nguyên linh hoạt theo nhu cầu.

- Tinh chỉnh và triển khai với lượng tử hóa

SageMaker AI hỗ trợ tối ưu hóa mô hình trước khi triển khai bằng các phương pháp lượng tử hóa nâng cao như AWQ, GPTQ, float16, int8, int4.

Giúp triển khai các mô hình lớn, ví dụ mô hình 32 tỷ tham số, trên các instance nhỏ như ml.g5.2xlarge với 24GB GPU memory, giảm đáng kể yêu cầu tài nguyên nhưng vẫn duy trì hiệu suất cao.

- Cân bằng tải suy luận và định tuyến tối ưu

SageMaker Endpoints hỗ trợ cân bằng tải và định tuyến tối ưu với nhiều chiến lược khác nhau, giúp linh hoạt điều chỉnh theo các trường hợp sử dụng khác nhau.

- Công thức tinh chỉnh SageMaker

SageMaker cung cấp các công thức sẵn có để tinh chỉnh nhanh các FMs công khai như Llama 3, Mistral, Mixtral.

Các công thức này sử dụng Amazon SageMaker HyperPod, một dịch vụ cung cấp cụm GPU tự phục hồi, tối ưu cho các tác vụ ML quy mô lớn, giúp đào tạo nhanh chóng và hiệu quả với hiệu suất bền vững.

Yêu cầu tiên quyết

Để theo dõi và thực hành các ví dụ mã trong bài viết này, hãy đảm bảo đáp ứng các yêu cầu sau:

Môi trường phát triển tích hợp – Bao gồm các yếu tố sau:

(Tùy chọn) Truy cập Amazon SageMaker Studio và JupyterLab IDE: Chúng tôi sẽ sử dụng môi trường Python runtime để xây dựng agentic workflows và triển khai LLMs.

Nên sử dụng JupyterLab IDE với các phiên bản Python 3.9, 3.10 hoặc 3.11.

Bạn cũng có thể thiết lập Amazon SageMaker Studio cho một người dùng.

Để biết thêm chi tiết, xem Use quick setup for Amazon SageMaker AI.

Tạo một SageMaker JupyterLab Space mới để có sổ tay JupyterLab nhanh chóng phục vụ thử nghiệm.

Để tìm hiểu thêm, tham khảo Boost productivity on Amazon SageMaker Studio: Introducing JupyterLab Spaces and generative AI tools.

IDE cục bộ: Bạn cũng có thể thực hành với IDE cục bộ (chẳng hạn như PyCharm hoặc VSCode), miễn là các Python runtimes đã được cấu hình để kết nối với AWS VPC (để triển khai mô hình trên SageMaker AI).

Quyền triển khai mô hình

Đảm bảo user execution role có quyền triển khai mô hình đến SageMaker real-time endpoint để suy luận.

Để biết thêm thông tin, tham khảo Deploy models for inference.

Truy cập Hugging Face Hub

Bạn cần có quyền truy cập vào trọng số mô hình deepseek-ai/DeepSeek-R1-Distill-Llama-8B từ môi trường của bạn.

Truy cập mã nguồn

Mã nguồn sử dụng trong bài viết này có sẵn trong kho GitHub

Lưu trữ LLM đơn giản hóa trên SageMaker AI

Trước khi điều phối agentic workflows với CrewAI sử dụng LLM, bước đầu tiên là lưu trữ và truy vấn LLM thông qua SageMaker real-time inference endpoints.

Có hai phương pháp chính để lưu trữ LLMs trên SageMaker AI:

- Triển khai từ SageMaker JumpStart

- Triển khai từ Hugging Face Hub

Triển khai DeepSeek từ SageMaker JumpStart

SageMaker JumpStart cung cấp quyền truy cập vào một loạt các Foundation Models (FMs) tiên tiến phục vụ cho nhiều tác vụ khác nhau, bao gồm viết nội dung, tạo mã code, trả lời câu hỏi, viết quảng cáo, tóm tắt, phân loại, truy xuất thông tin và nhiều hơn nữa. Nó đơn giản hóa quá trình tích hợp và bảo trì các FMs công khai, cho phép bạn truy cập, tùy chỉnh và tích hợp liền mạch chúng vào các quy trình ML của mình. Ngoài ra, SageMaker JumpStart còn cung cấp các mẫu giải pháp cấu hình hạ tầng cho các trường hợp sử dụng phổ biến, cùng với các sổ tay mẫu có thể thực thi nhằm tối ưu hóa phát triển ML với SageMaker AI.

CrewAI cung cấp một framework mạnh mẽ để phát triển các hệ thống multi-agent, tích hợp chặt chẽ với các dịch vụ của AWS, đặc biệt là SageMaker AI.Kiến trúc role-based agent của CrewAI cùng với khả năng giám sát hiệu suất toàn diện hoạt động song song với Amazon CloudWatch, giúp theo dõi và tối ưu hóa hiệu suất của các AI Agents trong môi trường sản xuất.

Tìm hiểu thêm: https://aws.amazon.com/cloudwatch/

Framework CrewAI vượt trội trong việc điều phối quy trình (workflow orchestration) và tuân thủ các tiêu chuẩn bảo mật cấp doanh nghiệp theo best practices của AWS, giúp doanh nghiệp triển khai hiệu quả các hệ thống agent-based phức tạp trong hạ tầng AWS.

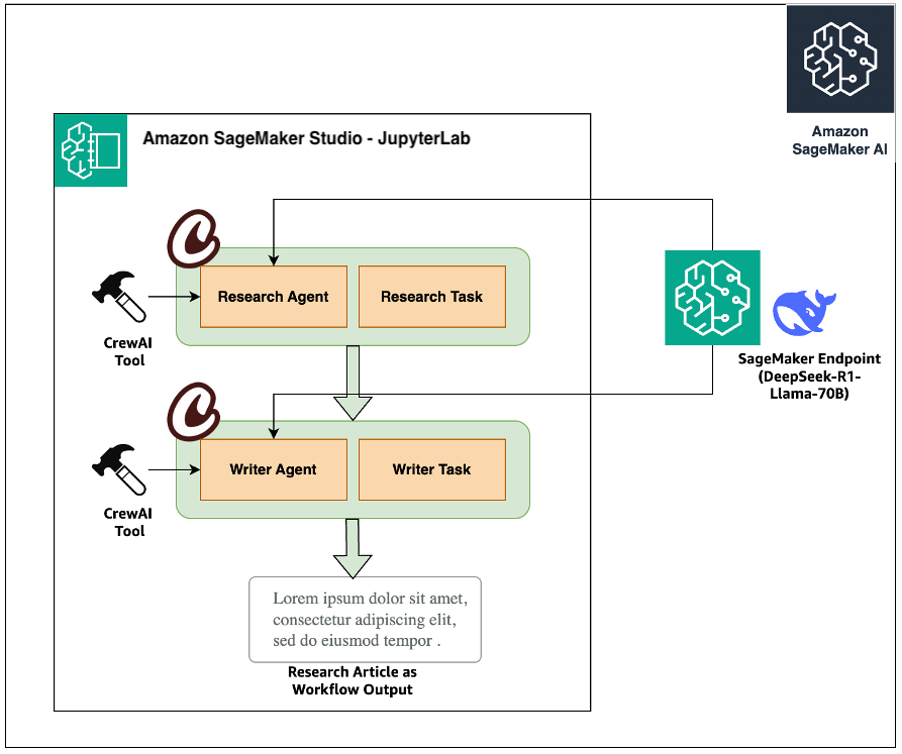

Trong bài viết này, chúng tôi hướng dẫn cách sử dụng CrewAI để tạo một multi-agent research workflow. Quy trình này bao gồm hai AI Agents:

Research Agent – tìm kiếm thông tin trên internet về một chủ đề cụ thể.

Writer Agent – đóng vai trò biên tập viên, định dạng và trình bày nội dung một cách rõ ràng, dễ đọc.

Ngoài ra, chúng tôi cũng hướng dẫn cách:

Triển khai và tích hợp một hoặc nhiều LLMs vào các workflow có cấu trúc.

Sử dụng các công cụ tự động hóa để thực hiện các hành động cụ thể.

Triển khai các workflows này trên SageMaker AI để sẵn sàng cho môi trường sản xuất.

Sơ đồ dưới đây minh họa kiến trúc giải pháp.

Ảnh chụp màn hình dưới đây minh họa một ví dụ về các mô hình có sẵn trên SageMaker JumpStart.

Để bắt đầu, hãy hoàn thành các bước sau:

- Cài đặt phiên bản mới nhất của sagemaker-python-sdk bằng pip.

- Chạy lệnh sau trong một ô Jupyter hoặc trong terminal của SageMaker Studio

- Liệt kê tất cả các LLMs có sẵn trong Hugging Face hoặc Meta JumpStart hub.Đoạn mã sau đây là một ví dụ về cách thực hiện điều này một cách lập trình bằng SageMaker Python SDK:

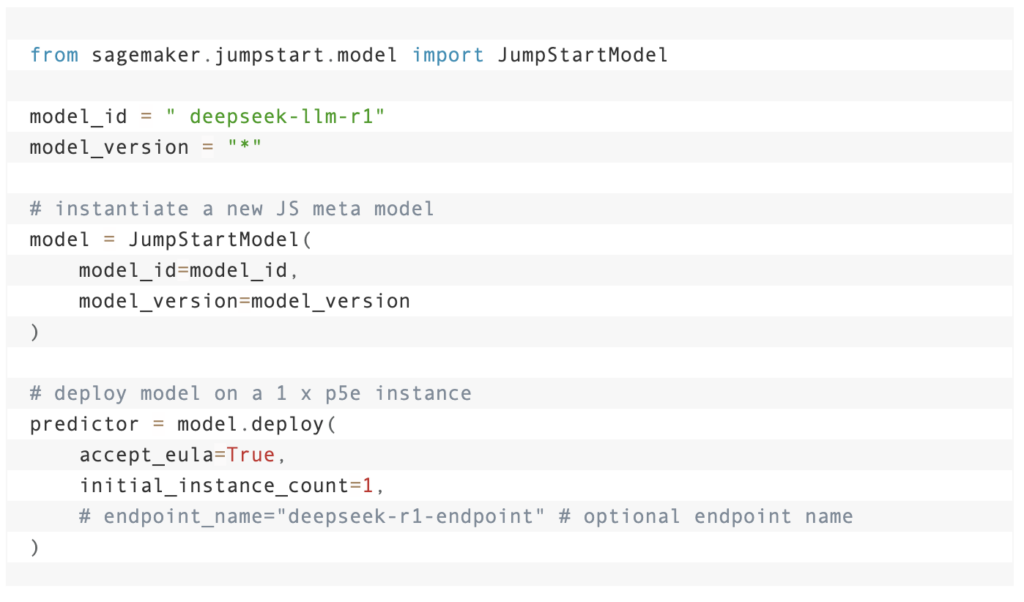

Triển khai mô hình **deepseek-llm-r1** trực tiếp từ **SageMaker JumpStart** chỉ yêu cầu vài dòng mã như sau: trong 4 giây

Ví dụ, việc triển khai mô hình deepseek-llm-r1 trực tiếp từ SageMaker JumpStart chỉ yêu cầu một vài dòng mã:

Triển khai DeepSeek từ Hugging Face Hub

Ngoài ra, bạn có thể triển khai mô hình ưa thích của mình trực tiếp từ Hugging Face Hub hoặc Bảng xếp hạng LLM ôm khuôn mặt đến điểm cuối SageMaker. Hugging Face LLM có thể được lưu trữ trên SageMaker bằng nhiều khung được hỗ trợ, chẳng hạn như NVIDIA Triton, vLLM và Hugging Face TGI. Để biết danh sách đầy đủ các hình ảnh vùng chứa deep learning được hỗ trợ, hãy tham khảo Bộ chứa Deep Learning có sẵn của Amazon SageMaker. Trong bài đăng này, chúng tôi sử dụng điểm cuối DeepSeek-R1-Distill-Llama-70B SageMaker bằng cách sử dụng vùng chứa TGI để suy luận AI tác nhân. Chúng tôi triển khai mô hình từ Hugging Face Hub bằng cách sử dụng bộ chứa TGI được tối ưu hóa của Amazon, giúp nâng cao hiệu suất cho LLM. Vùng chứa này được tối ưu hóa đặc biệt cho các tác vụ tạo văn bản và tự động chọn các tham số hiệu suất cao nhất cho cấu hình phần cứng nhất định. Để triển khai từ Hugging Face Hub, hãy tham khảo kho lưu trữ GitHub hoặc đoạn mã sau:

Điểm cuối DeepSeek-R1-Distill-Llama-70B mới sẽ ngừng hoạt động sau chưa đầy 10 phút. Nếu bạn muốn thay đổi mô hình từ DeepSeek sang mô hình khác từ trung tâm, bạn chỉ cần thay thế tham số sau hoặc tham khảo ví dụ triển khai DeepSeek trong kho GitHub sau. Để tìm hiểu thêm về các tham số triển khai có thể được cấu hình lại bên trong vùng chứa TGI khi chạy, hãy tham khảo kho lưu trữ GitHub sau đây về các đối số TGI.

Xây dựng một tác nhân đơn giản với CrewAI

CrewAI cung cấp khả năng tạo ra các điều phối tác nhân đa tác nhân và rất phức tạp bằng cách sử dụng LLM từ một số nhà cung cấp LLM, bao gồm SageMaker AI và Amazon Bedrock. Trong các bước sau, chúng tôi tạo một tác nhân đếm khối đơn giản để làm ví dụ.

Tạo tác nhân đếm khối

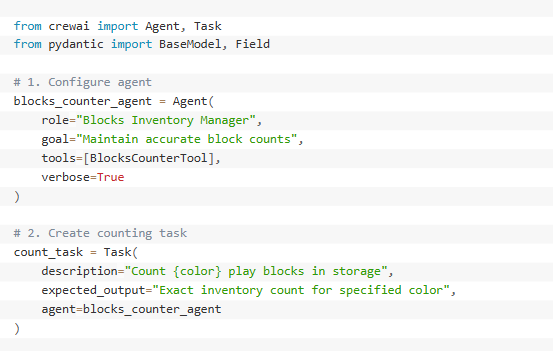

Đoạn mã sau thiết lập quy trình xử lý khối đơn giản bằng CrewAI với hai thành phần chính:

- Tạo tác nhân (blocks_counter_agent) – Tác nhân được định cấu hình với vai trò, mục tiêu và khả năng cụ thể. Tác nhân này được trang bị một công cụ có tên BlocksCounterTool.

Định nghĩa tác vụ (count_task) – Đây là tác vụ mà chúng tôi muốn tác nhân này thực thi. Nhiệm vụ này bao gồm một mẫu để đếm số lượng mỗi khối có màu, trong đó {color} sẽ được thay thế bằng màu thực của khối. Nhiệm vụ được giao cho block_counter_agent.

Như bạn có thể thấy trong đoạn mã trước, mỗi tác nhân bắt đầu bằng hai thành phần thiết yếu: một định nghĩa tác nhân thiết lập các đặc điểm cốt lõi của tác nhân (bao gồm vai trò, mục tiêu, cốt truyện, các công cụ có sẵn, điểm cuối mô hình LLM, v.v.) và một định nghĩa nhiệm vụ chỉ định những gì tác nhân cần hoàn thành, bao gồm mô tả chi tiết về công việc, kết quả đầu ra dự kiến và các công cụ mà tác nhân có thể sử dụng trong quá trình thực thi.

Cách tiếp cận có cấu trúc này đảm bảo rằng các tác nhân có cả danh tính và mục đích rõ ràng (thông qua định nghĩa tác tử) và phạm vi công việc được xác định rõ ràng (thông qua định nghĩa nhiệm vụ), cho phép chúng hoạt động hiệu quả trong phạm vi trách nhiệm được chỉ định của mình.

Công cụ dành cho Agentic AI

Công cụ là các chức năng đặc biệt giúp tác nhân AI có khả năng thực hiện các hành động cụ thể, như tìm kiếm trên Internet hoặc phân tích dữ liệu. Hãy coi chúng như những ứng dụng trên điện thoại thông minh—mỗi công cụ phục vụ một mục đích cụ thể và mở rộng những gì nhân viên có thể làm. Trong ví dụ của chúng tôi, BlocksCounterTool giúp tác nhân đếm số khối được sắp xếp theo màu sắc.

Các công cụ rất cần thiết vì chúng cho phép các tổng đài viên thực hiện các nhiệm vụ trong thế giới thực thay vì chỉ nghĩ về chúng. Nếu không có công cụ, các đặc vụ sẽ giống như những chiếc loa thông minh chỉ có thể nói chuyện—chúng có thể xử lý thông tin nhưng không thể thực hiện các hành động thực tế. Bằng cách thêm các công cụ, chúng tôi biến các tổng đài viên từ các chương trình trò chuyện đơn giản thành những trợ lý thực tế có thể hoàn thành các nhiệm vụ thực tế.

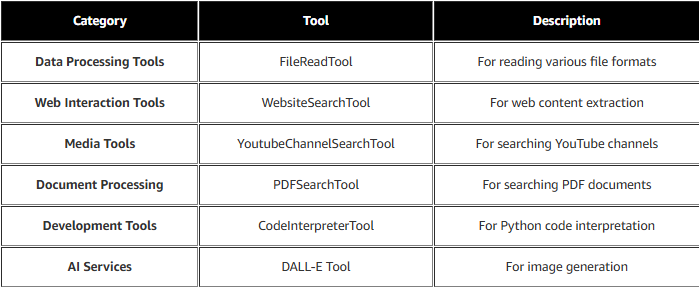

Các công cụ có sẵn với CrewAI

Crew AI cung cấp nhiều công cụ sẵn có để bạn sử dụng cùng với các đặc vụ và nhiệm vụ của mình. Bảng sau liệt kê một số công cụ có sẵn.

Xây dựng các công cụ tùy chỉnh với CrewAI

Bạn có thể xây dựng các công cụ tùy chỉnh trong CrewAI theo hai cách: bằng cách phân lớp BaseTool hoặc sử dụng trình trang trí @tool. Hãy xem tùy chọn phân lớp BaseTool sau để tạo BlocksCounterTool mà chúng tôi đã sử dụng trước đó:

Xây dựng quy trình làm việc đa tác nhân với CrewAI, DeepSeek-R1 và SageMaker AI

Hệ thống AI đa tác nhân thể hiện một cách tiếp cận mạnh mẽ để giải quyết vấn đề phức tạp, trong đó các tác nhân AI chuyên biệt làm việc cùng nhau dưới sự giám sát phối hợp. Bằng cách kết hợp khả năng điều phối quy trình công việc của CrewAI với LLM dựa trên SageMaker AI, các nhà phát triển có thể tạo ra các hệ thống phức tạp trong đó nhiều tác nhân cộng tác hiệu quả hướng tới một mục tiêu cụ thể. Mã được sử dụng trong bài đăng này có sẵn trong repo GitHub sau.

Hãy cùng nhau xây dựng một tác nhân nghiên cứu và tác nhân viết bài để cùng nhau tạo ra một bản PDF về một chủ đề. Chúng tôi sẽ sử dụng mô hình DeepSeek-R1 Distilled Llama 3.3 70B làm điểm cuối SageMaker cho suy luận LLM.

Xác định DeepSeek SageMaker LLM của riêng bạn (sử dụng lớp cơ sở LLM)

Đoạn mã sau tích hợp LLM được lưu trữ trên SageMaker với CrewAI bằng cách tạo một công cụ suy luận tùy chỉnh định dạng lời nhắc kèm theo hướng dẫn hệ thống cho phản hồi thực tế, sử dụng Boto3, thư viện lõi AWS, để gọi điểm cuối SageMaker và xử lý phản hồi bằng cách tách lý do (trước </think>) khỏi câu trả lời cuối cùng. Điều này cho phép các đặc vụ CrewAI sử dụng các mô hình đã triển khai trong khi vẫn duy trì các mẫu đầu ra có cấu trúc.

Đặt tên cho điểm cuối được chưng cất DeepSeek-R1

Đặt tên điểm cuối như đã xác định trước đó khi bạn triển khai DeepSeek từ Hugging Face Hub

Tạo công cụ suy luận DeepSeek

Giống như cách chúng tôi tạo BlocksCounterTool trước đó, hãy tạo một công cụ sử dụng điểm cuối DeepSeek để các đại lý của chúng tôi sử dụng. Ở đây chúng tôi sử dụng cùng một lớp con BaseTool nhưng chúng tôi ẩn nó trong triển khai lớp CustomTool trong sage_tools.py trong thư mục công cụ. Để biết thêm thông tin, hãy tham khảo kho lưu trữ GitHub.

Tạo một tác nhân nghiên cứu

Giống như tác nhân khối đơn giản mà chúng tôi đã xác định trước đó, chúng tôi làm theo cùng một mẫu ở đây để xác định tác nhân nghiên cứu. Sự khác biệt ở đây là chúng tôi cung cấp nhiều khả năng hơn cho tác nhân này. Chúng tôi đính kèm mô hình DeepSeek-R1 dựa trên SageMaker AI làm điểm cuối cho LLM.

Điều này giúp tác nhân nghiên cứu suy nghĩ chín chắn về việc xử lý thông tin bằng cách kết hợp cơ sở hạ tầng có thể mở rộng của SageMaker với khả năng suy luận nâng cao của DeepSeek-R1.

Tác nhân sử dụng LLM được lưu trữ trên SageMaker để phân tích các mẫu trong dữ liệu nghiên cứu, đánh giá độ tin cậy của nguồn và tổng hợp thông tin chuyên sâu từ nhiều đầu vào. Bằng cách sử dụng deepseek_tool, tác nhân có thể linh hoạt điều chỉnh chiến lược nghiên cứu của mình dựa trên những phát hiện trung gian, xác thực các giả thuyết thông qua việc đặt câu hỏi lặp đi lặp lại và duy trì nhận thức về bối cảnh trên thông tin phức tạp mà nó thu thập được.

Tạo một đại lý nhà văn

Tác nhân người viết được định cấu hình như một trình chỉnh sửa nội dung chuyên dụng lấy dữ liệu nghiên cứu và chuyển đổi nó thành nội dung được trau chuốt. Tác nhân này hoạt động như một phần của quy trình làm việc, trong đó tác nhân này nhận nghiên cứu từ tác nhân nghiên cứu và hoạt động như một biên tập viên bằng cách định dạng nội dung thành định dạng có thể đọc được. Tác nhân được sử dụng để viết và định dạng, và không giống như tác nhân nghiên cứu, nó không ủy quyền nhiệm vụ cho các tác nhân khác.

Xác định nhiệm vụ cho các đại lý

Nhiệm vụ trong CrewAI xác định các hoạt động cụ thể mà tổng đài viên cần thực hiện. Trong ví dụ này, chúng tôi có hai nhiệm vụ: một nhiệm vụ nghiên cứu xử lý các truy vấn và thu thập thông tin và một nhiệm vụ viết để chuyển dữ liệu nghiên cứu thành nội dung tinh tế.

Mỗi nhiệm vụ bao gồm một mô tả rõ ràng về những gì cần phải thực hiện, định dạng đầu ra dự kiến và chỉ định tác nhân nào sẽ thực hiện công việc. Cách tiếp cận có cấu trúc này đảm bảo rằng các tổng đài viên có trách nhiệm được xác định rõ ràng và kết quả phân phối rõ ràng.

Cùng với nhau, các tác vụ này tạo ra một quy trình làm việc trong đó một tác nhân nghiên cứu một chủ đề trên internet và một tác nhân khác thực hiện nghiên cứu này và định dạng nó thành nội dung có thể đọc được. Các tác vụ được tích hợp với công cụ DeepSeek để có khả năng xử lý ngôn ngữ nâng cao, cho phép triển khai sẵn sàng sản xuất trên SageMaker AI.

Xác định phi hành đoàn trong CrewAI

Một nhóm trong CrewAI đại diện cho một nhóm đặc vụ hợp tác làm việc cùng nhau để đạt được một loạt nhiệm vụ. Mỗi nhóm xác định chiến lược thực hiện nhiệm vụ, cộng tác của tổng đài viên và quy trình làm việc tổng thể. Trong ví dụ cụ thể này, quy trình tuần tự đảm bảo các nhiệm vụ được thực hiện lần lượt, theo một tiến trình tuyến tính. Có nhiều cách phối hợp phức tạp hơn giữa các tác nhân làm việc cùng nhau mà chúng ta sẽ thảo luận trong các bài đăng blog sau này.

Cách tiếp cận này lý tưởng cho các dự án yêu cầu nhiệm vụ phải được hoàn thành theo một thứ tự cụ thể. Quy trình làm việc tạo ra hai tác nhân: tác nhân nghiên cứu và tác nhân viết. Tác nhân nghiên cứu nghiên cứu một chủ đề trên internet, sau đó tác nhân viết thực hiện nghiên cứu này và hoạt động như một biên tập viên bằng cách định dạng nó thành định dạng có thể đọc được.

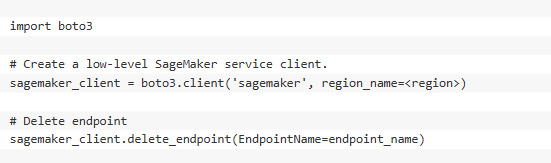

Clean up

Hoàn thành các bước sau để dọn sạch tài nguyên của bạn:

1.Xóa điểm cuối GPU DeekSeek-R1 của bạn:

2.Nếu bạn đang sử dụng sổ ghi chép SageMaker Studio JupyterLab, hãy tắt phiên bản sổ ghi chép JupyterLab.

Kết Luận

Trong bài đăng này, chúng tôi đã trình bày cách bạn có thể triển khai LLM như DeepSeek-R1—hoặc FM khác mà bạn chọn—từ các trung tâm mô hình phổ biến như SageMaker JumpStart hoặc Hugging Face Hub đến SageMaker AI để suy luận theo thời gian thực. Chúng tôi đã khám phá các khung suy luận như Ôm mặt TGI giúp hợp lý hóa việc triển khai đồng thời tích hợp các tính năng tối ưu hóa hiệu suất tích hợp sẵn để giảm thiểu độ trễ và tối đa hóa thông lượng. Ngoài ra, chúng tôi đã giới thiệu cách SDK Python thân thiện với nhà phát triển SageMaker đơn giản hóa việc điều phối điểm cuối, cho phép thử nghiệm liền mạch và mở rộng quy mô các ứng dụng hỗ trợ LLM.

Ngoài việc triển khai, bài đăng này còn cung cấp thông tin khám phá chuyên sâu về AI tác nhân, hướng dẫn bạn qua các nền tảng khái niệm, nguyên tắc thiết kế thực tế bằng cách sử dụng CrewAI và sự tích hợp liền mạch của các LLM tiên tiến như DeepSeek-R1 làm xương sống thông minh của quy trình làm việc tác nhân tự trị. Chúng tôi đã phác thảo thiết kế quy trình làm việc CrewAI tuần tự, minh họa cách trang bị cho các tác nhân hỗ trợ LLM các công cụ chuyên dụng cho phép truy xuất dữ liệu tự động, xử lý thời gian thực và tương tác với các hệ thống phức tạp bên ngoài.

Bây giờ đến lượt bạn thử nghiệm! Đi sâu vào mã có sẵn công khai của chúng tôi trên GitHub và bắt đầu xây dựng hệ thống AI hỗ trợ DeepSeek-R1 của riêng bạn trên SageMaker. Mở khóa biên giới tiếp theo của tự động hóa do AI điều khiển—có thể mở rộng liền mạch, thông minh và sẵn sàng cho sản xuất