Bài viết “Kiến trúc tổng thể và các thành phần cho giải pháp RAG dựa trên AI tạo sinh” trên blog AWS Public Sector cung cấp hướng dẫn chi tiết về cách xây dựng một hệ thống Retrieval-Augmented Generation (RAG) trên nền tảng AWS. Giải pháp này giúp các tổ chức, đặc biệt trong khu vực công, tự động hóa quá trình phát triển đề xuất, tiết kiệm thời gian và nâng cao chất lượng phản hồi đối với các yêu cầu như RFI hoặc RFP.

Giải pháp RAG trên AWS

Bài viết giới thiệu một cách tiếp cận thực tế để triển khai các giải pháp RAG, giúp các đối tác của AWS giảm đáng kể thời gian nghiên cứu và soạn thảo ban đầu cho các đề xuất, cho phép các nhóm tập trung vào các hoạt động chiến lược nhằm tăng tỷ lệ thành công.

Kiến trúc tổng quan

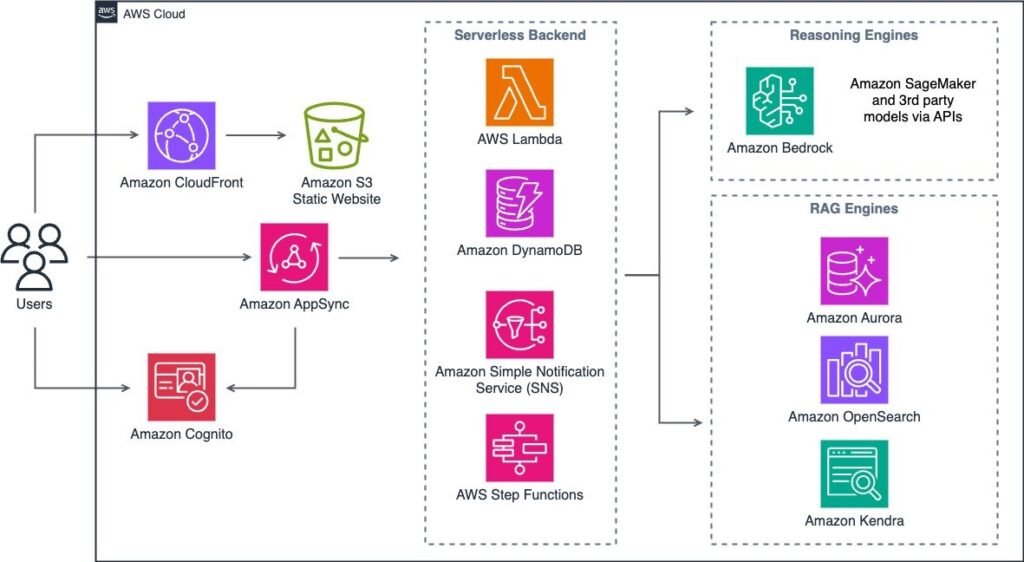

Kiến trúc giải pháp RAG bao gồm bốn mô-đun chính:

- Giao diện người dùng: Tương tác với người dùng cuối thông qua Amazon API Gateway.

- Điều phối: Quản lý luồng dữ liệu và các quy trình xử lý bằng cách sử dụng AWS Lambda và Amazon Bedrock agent.

- Embeddings: Sử dụng các mô hình nền tảng để chuyển đổi văn bản thành vector embeddings.

- Kho vector: Lưu trữ và tìm kiếm các embeddings trong các cơ sở dữ liệu vector như Amazon Kendra, Amazon OpenSearch hoặc các tùy chọn mã nguồn mở khác.Amazon Web Services, Inc.+1ragaboutit.com+1

Quy trình nạp dữ liệu vào kho vector

Đối tác có thể bắt đầu như thế nào?

- Amazon Bedrock: Hỗ trợ nhiều mô hình từ AWS, Anthropic, Cohere và Mistral, chẳng hạn như các mô hình mới nhất từ Amazon Nova. Xem thông báo gần đây để biết thêm chi tiết. Amazon Nova Family of Models hiện cung cấp sự kết hợp tốt nhất về độ chính xác, tốc độ và chi phí cho nhiều tác vụ, chẳng hạn như tác vụ RFx.

- Amazon SageMaker: Các mô hình tự lưu trữ từ Foundation, Jumpstart và HuggingFace.

- Các nhà cung cấp bên thứ ba thông qua API như Anthropic, Cohere, AI21 Labs, OpenAI, v.v. Xem các tích hợp LangChain có sẵn để biết danh sách đầy đủ.

Ngoài ra, Đối tác có thể sử dụng Amazon Bedrock trong SageMaker Unified Studio, một môi trường cộng tác được quản lý tích hợp cho phép các nhà phát triển nhanh chóng xây dựng và tùy chỉnh các ứng dụng AI tạo sinh. Nó cung cấp một giao diện trực quan với quyền truy cập vào các FM hiệu suất cao của Amazon Bedrock và các khả năng tùy chỉnh nâng cao, chẳng hạn như Cơ sở kiến thức, Guardrails, Agents và Flows. Amazon Bedrock trong SageMaker Unified Studio hợp lý hóa quá trình phát triển các ứng dụng AI tạo sinh bằng cách cung cấp trải nghiệm dễ dàng và dễ tiếp cận cho các nhà phát triển ở mọi cấp độ kỹ năng.

Kết luận

Với tốc độ phát triển nhanh chóng của AI sinh ngữ, việc xây dựng một kiến trúc RAG mô-đun trên AWS giúp các tổ chức tối ưu hóa giải pháp bằng cách sử dụng LLM và kho vector phù hợp nhất với trường hợp sử dụng kinh doanh của họ, đồng thời thúc đẩy việc tái sử dụng trên các giải pháp khác nhau trong tổ chức như chatbot, tìm kiếm, và hơn thế nữa.

Tìm hiểu thêm: https://osam.io/rag-tao-tang-cuong-truy-xuat-la-gi/

https://osam.io/agentic-ai-voi-deepseek-r1-crewai-va-amazon-sagemaker-ai-2/